El ex director general de Google, Eric Schmidt, comparó la IA con las armas nucleares y pidió un régimen de disuasión similar a la destrucción mutuamente asegurada que impide que los países más poderosos del mundo se destruyan entre sí.

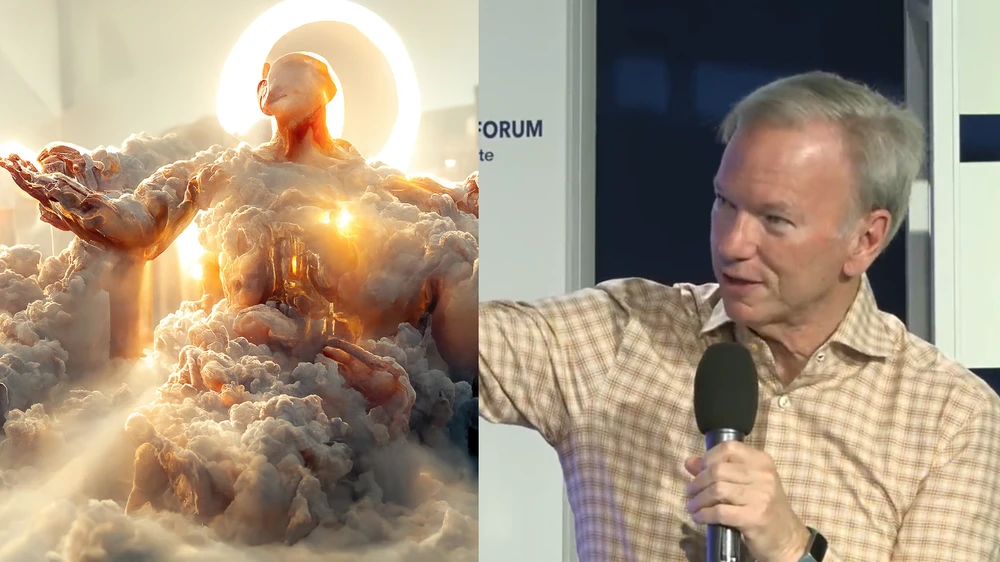

Schmidt habló de los peligros de la IA en el Foro de Seguridad de Aspen, en un panel sobre seguridad nacional e inteligencia artificial el 22 de julio. Al responder a una pregunta sobre el valor de la moral en la tecnología, Schmidt explicó que él mismo había sido ingenuo sobre el poder de la información en los primeros días de Google. A continuación, pidió que la tecnología estuviera más en consonancia con la ética y la moral de las personas a las que sirve e hizo una extraña comparación entre la IA y las armas nucleares.

"We are not ready for the negotiations that we need." – @ericschmidt #AspenSecurity pic.twitter.com/As749t6ZyU

— Aspen Security Forum (@AspenSecurity) July 22, 2022

Schmidt se imaginó un futuro cercano en el que China y Estados Unidos tuvieran que establecer un tratado en torno a la IA. “En los años 50 y 60, acabamos elaborando un mundo en el que había una norma de “no sorpresa” sobre las pruebas nucleares y finalmente se prohibieron”, dijo Schmidt. “Es un ejemplo de equilibrio de confianza, o de falta de confianza, es una regla de ‘no sorpresas’. Me preocupa mucho que la visión estadounidense de China como corrupta o comunista o lo que sea, y la visión china de Estados Unidos como fracasada… permita a la gente decir ‘Oh, Dios mío, están tramando algo’, y entonces comience algún tipo de enigma. Comenzar algún tipo de cosa en la que, porque te estás armando o preparando, entonces desencadenas al otro lado. No tenemos a nadie trabajando en eso, y sin embargo la IA es así de poderosa”.

La IA y el aprendizaje automático son una tecnología impresionante y a menudo incomprendida. En gran medida, no es tan inteligente como la gente cree que es. Puede producir obras de arte de nivel magistral, ganar a los humanos en Starcraft II y hacer llamadas telefónicas rudimentarias para los usuarios. Sin embargo, los intentos de conseguir que realice tareas más complicadas, como conducir un coche por una gran ciudad, no han ido muy bien.

Schmidt imagina un futuro cercano en el que tanto China como EE.UU. tienen preocupaciones de seguridad que obligan a una especie de tratado de disuasión entre ellos en torno a la IA. Habla de los años 50 y 60, cuando la diplomacia elaboró una serie de controles en torno a las armas más mortíferas del planeta. Pero para que el mundo llegara al punto de instituir el Tratado de Prohibición de Pruebas Nucleares, el SALT II y otras leyes históricas, hicieron falta décadas de explosiones nucleares y, sobre todo, la destrucción de Hiroshima y Nagasaki.

Las dos ciudades japonesas que Estados Unidos destruyó al final de la Segunda Guerra Mundial mataron a decenas de miles de personas y demostraron al mundo el horror eterno de las armas nucleares. Los gobiernos de Rusia y China se apresuraron entonces a adquirir las armas. La forma en que vivimos con la posibilidad de que estas armas se utilicen es a través de algo llamado destrucción mutua asegurada (MAD), una teoría de la disuasión que asegura que si un país lanza una bomba nuclear, es posible que todos los demás países también lo hagan. No utilizamos el arma más destructiva del planeta por la posibilidad de que al hacerlo se destruya, como mínimo, la civilización de todo el mundo.

A pesar de los pintorescos comentarios de Schmidt, no queremos ni necesitamos la MAD para la IA. Por un lado, la IA no ha demostrado ser ni de lejos tan destructiva como las armas nucleares. Pero la gente en posiciones de poder teme esta nueva tecnología y, normalmente, por todas las razones equivocadas. La gente incluso ha sugerido dar el control de las armas nucleares a la IA, con la teoría de que serían mejores árbitros de su uso que los humanos.

El problema de la IA no es que tenga la fuerza potencialmente destructora del mundo de un arma nuclear; es que la IA sólo es tan buena como las personas que la han diseñado y que reflejan los valores de sus creadores. La IA sufre el clásico problema de “basura que entra, basura que sale”: Los algoritmos racistas hacen robots racistas, toda IA lleva los prejuicios de sus creadores, y un chatbot entrenado en 4chan se vuelve vil.

Esto es algo que Demis Hassabis -el director general de DeepMind, que entrenó a la IA que está venciendo a los jugadores de Starcraft II- parece entender mejor que Schmidt. En una entrevista realizada en julio en el podcast de Lex Fridman, éste le preguntó a Hassabis cómo podría controlarse una tecnología tan poderosa como la IA y cómo podría el propio Hassabis evitar ser corrompido por el poder.

La respuesta de Hassabis se refiere a sí mismo. “La IA es una idea demasiado grande”, dijo. “Importa quién construye [la IA], de qué culturas proceden y qué valores tienen los constructores de los sistemas de IA. Los sistemas de IA aprenderán por sí mismos… pero habrá un residuo en el sistema de la cultura y los valores de los creadores de ese sistema”.

La IA es un reflejo de su creador. No puede arrasar una ciudad con una explosión de 1,2 megatones. No a menos que un humano le enseñe a hacerlo.