Indice de Contenido

- Los principales enfoques del aprendizaje automático

- Redes neuronales profundas

- Redes neuronales convolucionales

- Google Brain: La primera red neuronal a gran escala

- DeepMind: Aprender de la experiencia

- AlphaGo: Derrotando a los mejores jugadores de Go

- OpenAI

- Software 2.0

- Duelo de redes neuronales

- Los datos son el nuevo petróleo

- Privacidad de datos

- Procesadores de aprendizaje profundo

El cambio fundamental en la resolución de problemas que el razonamiento probabilístico trajo a la IA de 1993 a 2011 fue un gran paso adelante, pero la probabilidad y las estadísticas solo llevaron a los desarrolladores hasta ahora. Geoffrey Hinton creó una técnica innovadora llamada retropropagación para marcar el comienzo de la próxima era de la inteligencia artificial: el aprendizaje profundo. Su trabajo con redes neuronales multicapa es la base del desarrollo moderno de la IA.

El aprendizaje profundo es una clase de métodos de aprendizaje automático que utiliza redes neuronales multicapa que se entrenan a través de técnicas como el aprendizaje supervisado, no supervisado y de refuerzo.

En 2012, Geoffrey Hinton y los estudiantes de su laboratorio demostraron que las redes neuronales profundas, entrenadas con retropropagación, superan a los mejores algoritmos en reconocimiento de imágenes por un amplio margen.

Justo después de eso, el aprendizaje profundo despegó desbloqueando un montón de potencial. Su primer uso a gran escala fue con Google Brain. Dirigido por Andrew Ng, que alimentó 10 millones de vídeos de YouTube a 1.000 ordenadores, el sistema fue capaz de reconocer gatos y detectar caras sin reglas codificadas.

Luego, DeepMind utilizó el aprendizaje profundo para crear el primer sistema de aprendizaje automático para derrotar a los mejores jugadores de Go del mundo. DeepMind combinó técnicas de jugadores anteriores de Go, utilizando la búsqueda en el árbol de Monte Carlo combinada con dos redes neuronales profundas que calcularon la probabilidad de los próximos movimientos posibles y las posibilidades de ganar de cada uno de ellos. Este fue un gran avance debido a lo difícil que es el juego en comparación con otros juegos como el ajedrez. El número total de estados es mayor en comparación con el ajedrez.

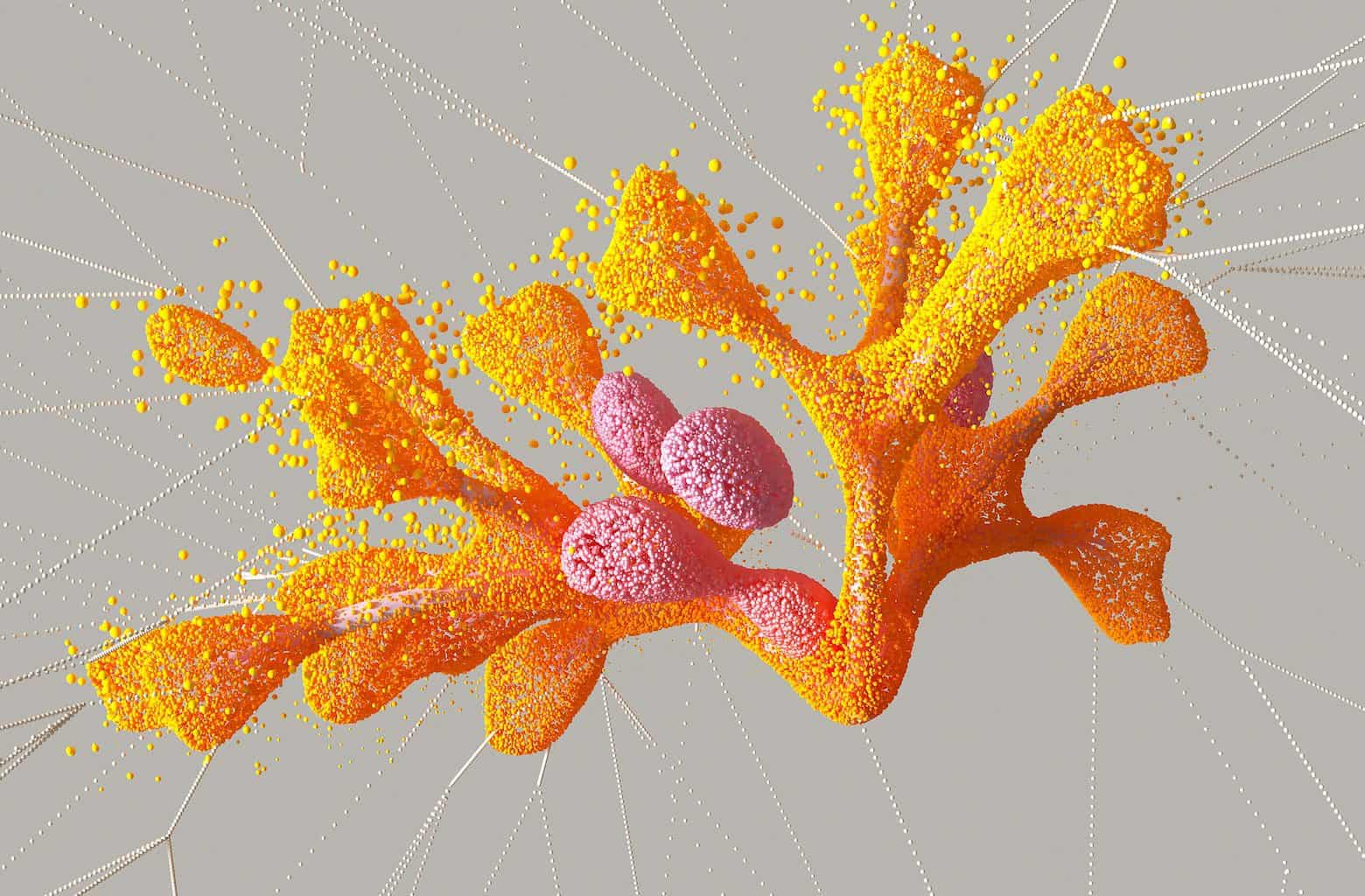

El mismo equipo utilizó redes neuronales profundas para determinar la estructura 3D de las proteínas en función de su genoma, creando lo que se conoce como AlphaFold. Esta fue una solución para un gran desafío de 50 años en biología. *

Surgieron nuevas técnicas, incluida la creación de redes adversarias generativas, que tienen dos redes neuronales jugando un juego de gato y ratón en el que una crea imágenes falsas que se parecen a las reales alimentadas y la otra decide si son reales. Esta nueva técnica se ha utilizado para crear imágenes que parecen reales.

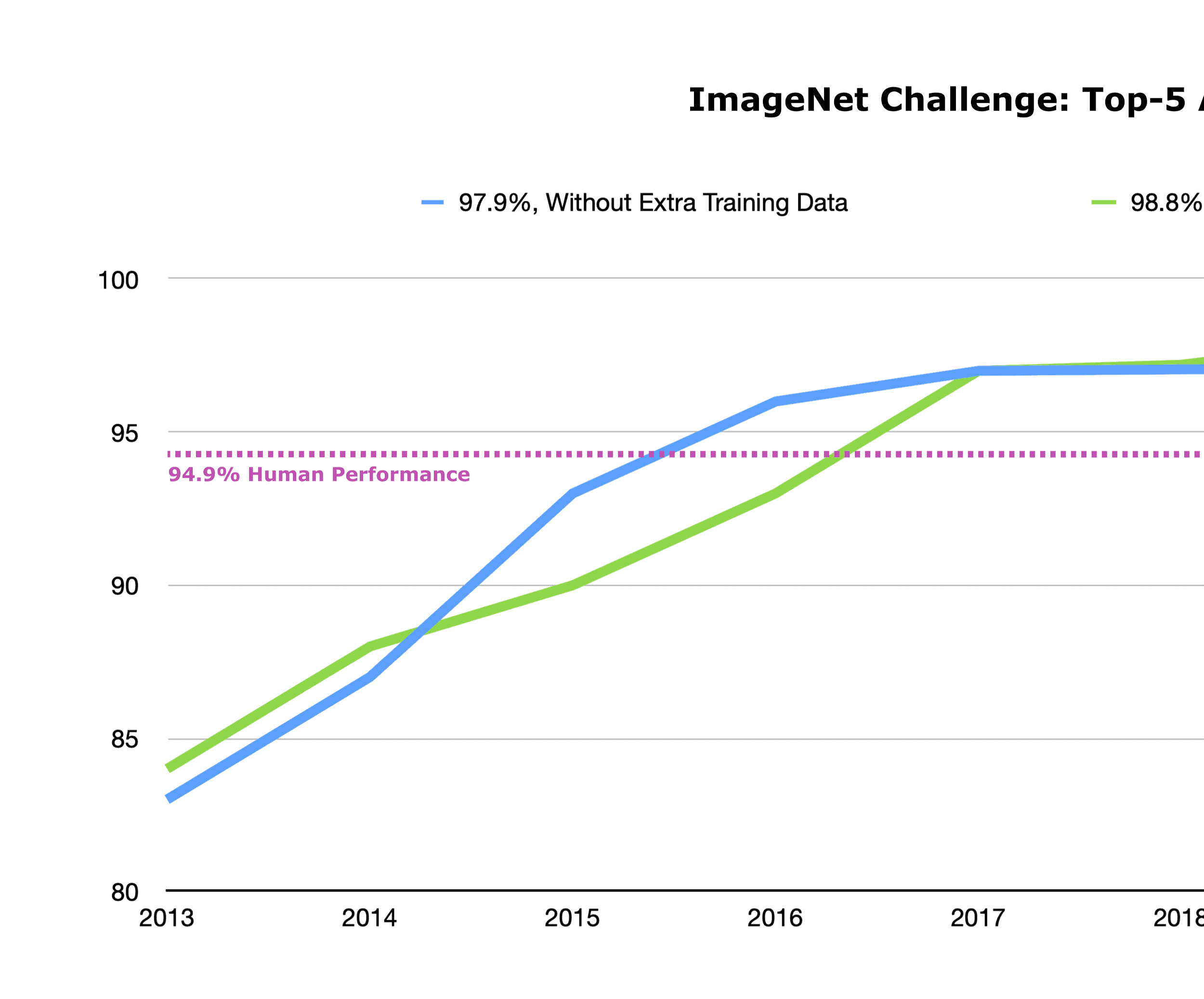

Si bien el aprendizaje profundo requirió la creación de un nuevo sistema de software, TensorFlow, y un nuevo hardware, unidades de procesamiento gráfico (GPU) y unidades de procesamiento de tensores (TPU), lo que más se necesitaba era una forma de entrenar estas redes de neuroales profundos. El aprendizaje profundo solo tiene tanto éxito como los datos de entrenamiento. El trabajo de Fei-Fei Li creó un conjunto de datos instrumental, ImageNet, que se utilizó no solo para entrenar los algoritmos, sino también como punto de referencia en el campo. Sin esos datos, el aprendizaje profundo no estaría donde está hoy.

Desafortunadamente, con la recopilación de datos a una escala tan masiva, los problemas de privacidad se convierten en una preocupación. Si bien hemos llegado a esperar violaciones de datos, no tiene por qué ser así. Apple y Google continúan afinando los enfoques que no requieren la recopilación de datos personales. La privacidad diferencial y el aprendizaje federado son ejemplos de la tecnología actual. Permiten a los modelos actualizarse y aprender sin filtrar información individual sobre los datos que se utilizan para el entrenamiento.

Los principales enfoques del aprendizaje automático

Aprendí muy pronto la diferencia entre saber el nombre de algo y saber algo.Richard Feynman*

Los algoritmos de aprendizaje automático generalmente aprenden analizando datos e infiriendo qué tipo de modelo o parámetros debería tener un modelo o interactuando con el entorno y obteniendo retroalimentación de él. Los humanos pueden anotar estos datos o no, y el entorno puede ser simulado o el mundo real.

Las tres categorías principales que los algoritmos de aprendizaje automático pueden utilizar para aprender son el aprendizaje supervisado, el aprendizaje no supervisado y el aprendizaje por refuerzo. Se pueden utilizar otras técnicas, como estrategias de evolución o aprendizaje semisupervisado, pero no son tan ampliamente utilizadas ni tan exitosas como las tres técnicas anteriores.

APRENDIZAJE SUPERVISADO

El aprendizaje supervisado se ha utilizado ampliamente en la formación de ordenadores para etiquetar objetos en imágenes y traducir la voz a texto. Digamos que eres dueño de un negocio de bienes raíces y uno de los aspectos más importantes del éxito es averiguar el precio de una casa cuando entra en el mercado. Determinar ese precio es extremadamente importante para completar una venta, lo que hace feliz tanto al comprador como al vendedor. Usted, como agente inmobiliario experimentado, puede calcular el precio de una casa en función de sus conocimientos previos.

Pero a medida que tu negocio crece, necesitas ayuda, por lo que contratas a nuevos agentes inmobiliarios. Para tener éxito, también necesitan determinar el precio de una casa en el mercado. En aras de ayudar a estas personas inexpertas, escribe el valor de las casas que la empresa ya compró y vendió, en función del tamaño, el vecindario y varios detalles, incluido el número de baños y dormitorios y el precio de venta final.

| DORMITORIOS | PIES CUADRADOS | VECINDARIO | PRECIO DE VENTA |

|---|---|---|---|

| 2 | 1.000 | Colina Potrero | 300 000 $ |

| 1 | 700 | Parche para perros | 250 000 $ |

| 2 | 1.250 | haoma | 500 000 $ |

| 1 | 800 | Colina Potrero | 200 000 $ |

| 1 | 400 | haoma | 150 000 $ |

Tabla: Datos de muestra para un algoritmo de aprendizaje supervisado.

Esta información se llama datos de entrenamiento; es decir, son datos de ejemplo que contienen los factores o características que pueden influir en el precio de una casa además del precio de venta final. Los nuevos empleados analizan todos estos datos para empezar a aprender qué factores influyen en el precio final de una casa. Por ejemplo, el número de habitaciones podría ser un gran indicador de precio, pero el tamaño de la casa puede no ser necesariamente tan importante. Si los agentes inmobiliarios inexpertos tienen que determinar el precio de una casa nueva que entra en el mercado, simplemente comprueban para encontrar una casa que sea más similar y usan esa información para determinar el precio.

| DORMITORIOS | PIES CUADRADOS | VECINDARIO | PRECIO DE VENTA |

|---|---|---|---|

| 2 | 1.000 | Parche para perros | ??? |

Tabla: Falta información que el algoritmo determinará.

Así es precisamente como los algoritmos aprenden de los datos de entrenamiento con un método llamado aprendizaje supervisado. El algoritmo conoce el precio de algunas de las casas en el mercado, y necesita averiguar cómo predecir el nuevo precio de una casa que está entrando en el mercado. En el aprendizaje supervisado, la computadora, en lugar de los agentes inmobiliarios, calcula la relación entre los puntos de datos. El valor que el ordenador necesita predecir se llama etiqueta. En los datos de entrenamiento, se proporcionan las etiquetas. Cuando hay un nuevo punto de datos cuyo valor, la etiqueta, no está definido, el ordenador estima el valor que falta comparándolo con los que ya ha visto.

APRENDIZAJE NO SUPERVISADO

El aprendizaje no supervisado es una técnica de aprendizaje automático que aprende patrones con datos sin etiquetar.

En nuestro ejemplo, el aprendizaje no supervisado es similar al aprendizaje supervisado, pero el precio de cada casa no forma parte de la información incluida en los datos de entrenamiento. Los datos no están etiquetados.

| DORMITORIOS | PIES CUADRADOS | VECINDARIO |

|---|---|---|

| 3 | 2.000 | Parche para perros |

| 2 | 800 | Colina Potrero |

| 3 | 1.000 | haoma |

| 1 | 600 | Parche para perros |

| 4 | 2.000 | Colina Potrero |

Tabla: Datos de entrenamiento de muestra para un algoritmo de aprendizaje no supervisado.

Incluso sin el precio de las casas, puedes descubrir patrones a partir de los datos. Por ejemplo, los datos pueden decir que hay una gran cantidad de casas con dos dormitorios y que el tamaño promedio de una casa en el mercado es de alrededor de 1.200 pies cuadrados. Otra información que se podría extraer es que muy pocas casas en el mercado en un determinado vecindario tienen cuatro dormitorios, o que existen cinco estilos principales de casas. Y con esa información, si una casa nueva entra en el mercado, puede averiguar las casas más similares mirando las características o identificando que la casa es un valor atípico. Esto es lo que hacen los algoritmos de aprendizaje no supervisados.

APRENDIZAJE DE REFUERZO

Las dos formas de aprendizaje anteriores se basan únicamente en los datos dados al algoritmo. El proceso de aprendizaje por refuerzo es diferente: el algoritmo aprende interactuando con el entorno. Recibe comentarios del medio ambiente, ya sea recompensando el buen comportamiento o castigando lo malo. Veamos un ejemplo de aprendizaje por refuerzo.

Digamos que tienes un perro, Spot, a quien quieres entrenar para sentarse al mando. ¿Por dónde empiezas? Una forma es mostrarle a Spot lo que significa “sentado” poniendo su trasero en el suelo. La otra forma es recompensar a Spot con un regalo cada vez que pone su trasero en el suelo. Con el tiempo, Spot se entera de que cada vez que se sienta al mando recibe un regalo y que este es un comportamiento recompensado.

El aprendizaje de refuerzo funciona de la misma manera. Es un marco construido sobre esta visión que puedes enseñar a los agentes inteligentes, como un perro o una red de neuroales profundos, a lograr una determinada tarea recompensándolos cuando realizan correctamente la tarea. Y cada vez que el agente logra el resultado deseado, su posibilidad de repetir dicha acción aumenta debido a la recompensa. Los agentes son algoritmos que procesan la entrada y actúan como una voz para la salida. Spot es el agente en el ejemplo.

El aprendizaje de refuerzo es un método de entrenamiento de aprendizaje automático basado en recompensar los comportamientos deseados y/o castigar a los no deseados.

El aprendizaje de refuerzo como marco de aprendizaje es interesante, pero los algoritmos asociados son el aspecto más importante. La forma en que trabajan es definiendo la recompensa que el agente recibe una vez que alcanza un estado, como sentarse. La formulación de algoritmos de refuerzo es encontrar una política, como un mapeo específico de los estados a las acciones a tomar, que maximice la recompensa esperada para que el agente aprenda el comportamiento que maximiza la recompensa (el tratamiento).

En la formulación de aprendizaje de refuerzo, el entorno da la recompensa: el agente no descubre la recompensa en sí, sino que solo la recibe interactuando con el entorno y golpeando el comportamiento esperado. Un problema con esto es que el agente a veces tarda mucho tiempo en recibir una recompensa. Por ejemplo, si Spot nunca se sienta, entonces nunca recibe un regalo y no aprende a sentarse. O, digamos que quieres que un agente aprenda a navegar por un laberinto y la recompensa solo se da cuando el agente sale del laberinto. Si el agente tarda demasiado en irse, entonces es difícil decir qué acciones tomó el agente que le ayudaron a salir del laberinto. Otro problema es que el agente solo aprende de sus propios éxitos y fracasos. Ese no es necesariamente el caso de los humanos en el mundo real. Nadie necesita conducir por un acantilado miles de veces para aprender a conducir. La gente puede obtener recompensas a partir de la observación.

ALGORITMOS DE REFUERZO

Los siguientes dos pasos definen los algoritmos de refuerzo:

- Añade aleatoriedad a las acciones del agente para que intente algo diferente, y

- Si el resultado fue mejor de lo esperado, haz más de lo mismo en el futuro.

Añadir aleatoriedad a las acciones garantiza que el agente busque las acciones correctas a realizar. Y si el resultado es el esperado, entonces el agente intenta hacer más de lo mismo en el futuro. Sin embargo, el agente no necesariamente repite exactamente las mismas acciones, porque todavía intenta mejorar explorando acciones potencialmente mejores. Aunque los algoritmos de refuerzo se pueden explicar fácilmente, no necesariamente funcionan para todos los problemas. Para reforzar el aprendizaje de trabajar, la situación debe tener una recompensa, y no siempre es fácil definir lo que debe o no debe ser recompensado.

Los algoritmos de refuerzo también pueden ser contraproducente. Digamos que un agente es recompensado por el número de clips que hace. Si el agente aprende a transformar algo en clips, podría ser que lo convierta todo en clips. * Si la recompensa no castiga al agente cuando crea demasiados clips de papel, el agente puede comportarse mal. Los algoritmos de aprendizaje de refuerzo también son en su mayoría ineficientes porque pasan mucho tiempo buscando la solución correcta y añadiendo acciones aleatorias para encontrar el comportamiento correcto. Incluso con estas limitaciones, pueden realizar una abrumadora variedad de tareas, como jugar a juegos de Go a nivel sobrehumano y hacer que los brazos robóticos agarren objetos.

Otra forma de aprender que es particularmente útil con los juegos es hacer que varios agentes jueguen entre sí. Dos ejemplos clásicos son el ajedrez o el Go, donde dos agentes compiten entre sí. Los agentes aprenden qué acciones tomar al ser recompensados cuando ganan el juego. Esta técnica se llama juego personal, y se puede utilizar no solo con un algoritmo de aprendizaje de refuerzo, sino también para generar datos. En Go, por ejemplo, se puede usar para averiguar qué jugadas tienen más probabilidades de hacer ganar a un jugador. Self-play genera datos a partir de la potencia informática, es decir, del ordenador que se reproduce a sí mismo.

Las tres categorías de aprendizaje son útiles en diferentes situaciones. Utilice el aprendizaje supervisado cuando hay muchos datos disponibles que las personas etiquetan, como cuando otros etiquetan a las personas en Facebook.El aprendizaje no supervisado se utiliza principalmente cuando no hay mucha información sobre los puntos de datos que el sistema necesita averiguar, como en los ataques cibernéticos. Se puede inferir que están siendo atacados mirando los datos y viendo comportamientos extraños que no estaban allí antes del ataque. El último, el aprendizaje de refuerzo, se utiliza principalmente cuando no hay muchos datos sobre la tarea que el agente necesita lograr, pero hay objetivos claros, como ganar un juego de ajedrez. Los algoritmos de aprendizaje automático, más específicamente los algoritmos de aprendizaje profundo, se entrenan con estos tres modos de aprendizaje.

Redes neuronales profundas

- ¿Qué es una red neuronal?

- ¿Qué es la retropropagación?

- ¿Qué son las redes neuronales convolucionales?

Siempre he estado convencido de que la única manera de hacer que la inteligencia artificial funcione es hacer el cálculo de una manera similar al cerebro humano. Ese es el objetivo que he estado persiguiendo. Estamos progresando, aunque todavía tenemos mucho que aprender sobre cómo funciona realmente el cerebro.Geoffrey Hinton*

EL AVANCE

El aprendizaje profundo es un tipo de algoritmo de aprendizaje automático que utiliza redes neuronales multicapa y retropropagación como técnica para entrenar las redes neuronales. El campo fue creado por Geoffrey Hinton, el tatarabuelo de George Boole, cuyo álgebra booleana es una piedra angular de la computación digital. *

La evolución del aprendizaje profundo fue un proceso largo, por lo que debemos retroceder en el tiempo para entenderlo. La técnica surgió por primera vez en el campo de la teoría del control en la década de 1950. Una de las primeras aplicaciones consistió en optimizar los empujes de las naves espaciales Apolo mientras se dirigían a la luna.

Las primeras redes neuronales, llamadas perceptrones, fueron el primer paso hacia la inteligencia humana. Sin embargo, un libro de 1969, Perceptrons: An Introduction to Computational Geometry de Marvin Minsky y Seymour Papert, demostró las limitaciones extremas de la tecnología al mostrar que una red superficial, con solo unas pocas capas, solo podía realizar las funciones computacionales más básicas. En ese momento, su libro fue un gran revés en el campo de las redes neuronales y la IA.

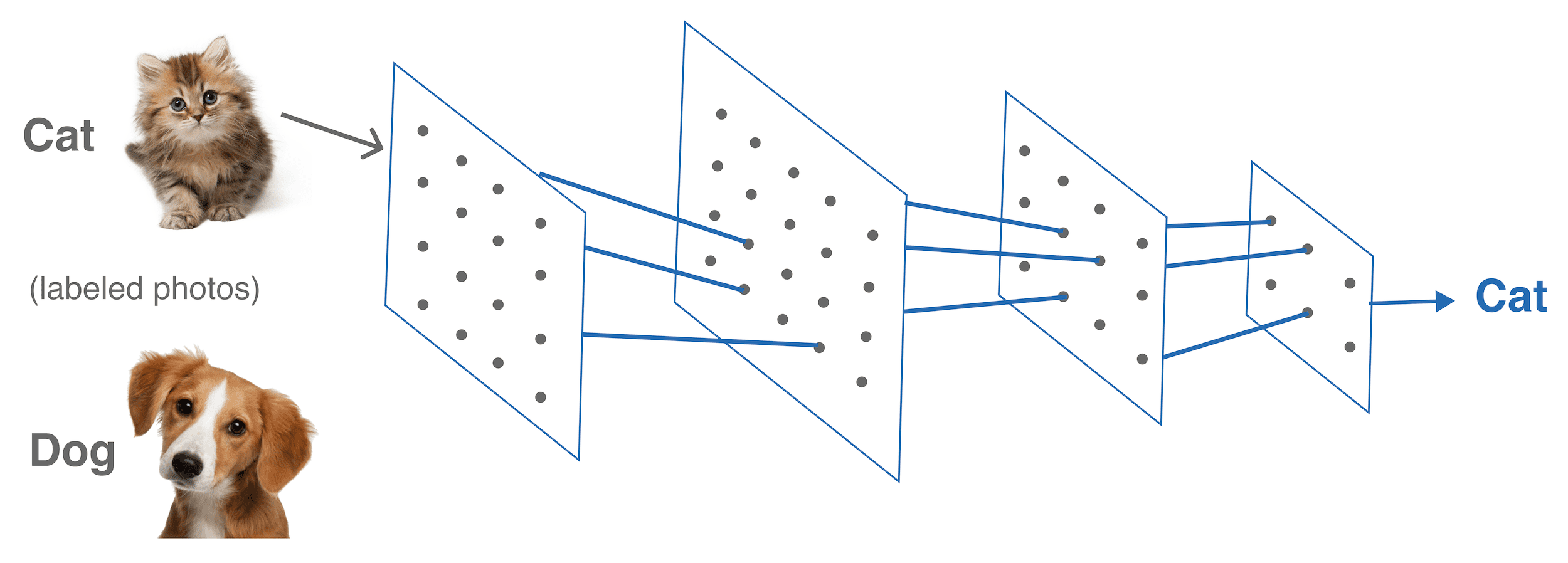

Para superar las limitaciones señaladas en el libro de Minsky y Papert requiere redes neuronales de múltiples capas. Para crear una red neuronal multicapa para realizar una determinada tarea, los investigadores primero determinan cómo se verá la red neuronal determinando qué neuronas se conectan a qué otras. Pero para terminar de crear una red neuronal de este tipo, los investigadores necesitan encontrar los pesos entre cada una de las neuronas, cuánto afecta la producción de una neurona a la siguiente. El paso de entrenamiento en el aprendizaje profundo suele hacer eso. En ese paso, la red neuronal se presenta con ejemplos de datos y el software de entrenamiento calcula los pesos correctos para cada conexión en la red neuronal para que produzca los resultados previstos; por ejemplo, si la red neuronal está entrenada para clasificar imágenes, entonces cuando se presenta con imágenes que contienen gatos, dice que hay un gato allí.

La retropropagación es un algoritmo que ajusta los pesos de tal manera que cada vez que los cambias, la red neuronal se acerca a la salida correcta más rápido de lo que era posible anteriormente. La forma en que esto funciona es que las neuronas que están más cerca de la salida son las que se ajustan primero. Luego, después de que toda la clasificación de las imágenes no se pueda mejorar ajustando, la capa anterior se actualiza para mejorar la clasificación. Este proceso continúa hasta que la primera capa de neuronas es la que se ajusta.

En 1986, Hinton publicó el artículo seminal sobre redes neuronales profundas (DNN), “Aprender representaciones mediante errores de retropropagación”, con sus colegas David Rumelhart y Ronald Williams. * El artículo introdujo la idea de retropropagación, una técnica matemática simple que condujo a grandes avances en el aprendizaje profundo.

La técnica de retropropagación desarrollada por Hinton encuentra los pesos de cada neurona en una red neuronal multicapa de manera más eficiente. Antes de esta técnica, se tardó una cantidad exponencial de tiempo en encontrar los pesos, también conocidos como coeficientes, para una red neuronal multicapa, lo que hizo extremadamente difícil encontrar los coeficientes correctos para cada neurona. Antes, tardó meses o años en entrenar una red neuronal para ser la correcta para las entradas, pero esta nueva técnica tomó significativamente menos tiempo.

El avance de Hilton también mostró que la retropropagación permitió entrenar fácilmente una red neuronal que tenía más de dos o tres capas, rompiendo la limitación impuesta por las redes neuronales poco profundas. La retropropagación permitió la innovación de encontrar los pesos exactos para que una red neuronal multicapa creara la salida o el resultado deseado. Este desarrollo permitió a los científicos entrenar redes neuronales más potentes, haciéndolas mucho más relevantes. En comparación, una de las redes neuronales de mayor rendimiento en la visión, llamada Inception, tiene aproximadamente 22 capas de neuronas.

¿QUÉ ES UNA RED NEURONAL?

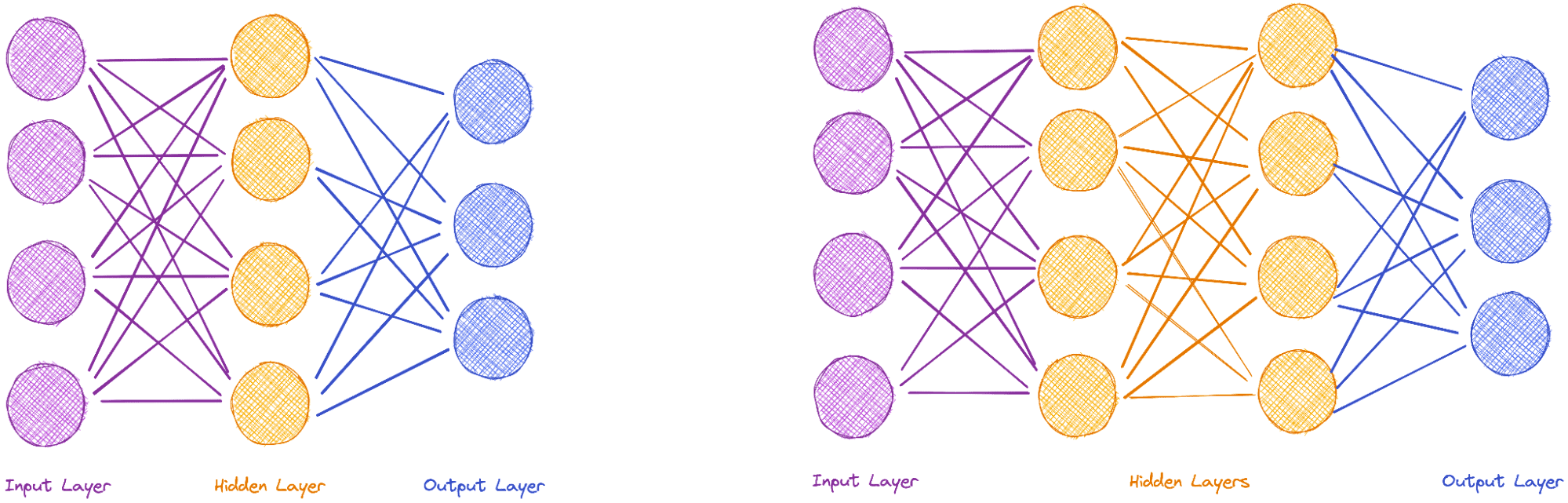

La siguiente figura muestra un ejemplo tanto de una red neuronal simple (SNN) como de una red neuronal de aprendizaje profundo (DLNN). A la izquierda de cada red se encuentra la capa de entrada, representada por los puntos rojos. Estos reciben los datos de entrada. En el SNN, las neuronas de capa oculta se utilizan para hacer los ajustes necesarios para alcanzar la salida (puntulos azules) en el lado derecho. Por el contrario, el uso de más de una capa caracteriza el DLNN, lo que permite un comportamiento mucho más complejo que puede manejar una entrada más involucrada.

La forma en que los investigadores suelen desarrollar una red neuronal es la primera vez definiendo su arquitectura: el número de neuronas y cómo están dispuestas. Pero los parámetros de las neuronas dentro de la red neuronal deben determinar. Para ello, los investigadores inicializan los pesos de la red neuronal con números aleatorios. Después de eso, le dan los datos de entrada y determinan si la salida es similar a la que quieren. Si no lo es, entonces actualizan los pesos de las neuronas hasta que la salida sea la más cercana a lo que muestran los datos de entrenamiento.

Por ejemplo, digamos que quieres clasificar algunas imágenes como que contienen un perrito caliente y otras como que no contienen un perro caliente. Para ello, alimentas las imágenes de la red neuronal que contienen perritos calientes y otras que no lo hacen, que son los datos de entrenamiento. Después del entrenamiento inicial, la red neuronal recibe nuevas imágenes y necesita determinar si contienen un perrito caliente o no.

Estas imágenes de entrada están compuestas por una matriz de números, que representa cada píxel. La red neuronal pasa a través de la imagen, y cada neurona aplica la multiplicación de matrices, utilizando los pesos internos, a los números de la imagen, generando una nueva imagen. Las salidas de las neuronas son una pila de imágenes de menor resolución, que luego se multiplican por las neuronas de la siguiente capa. En la capa final, sale un número que representa la solución. En este caso, si es positivo, significa que la imagen contiene un perrito caliente, y si es negativo, significa que no contiene un perrito caliente.

El problema es que los pesos no se definen al principio. El proceso de encontrar los pesos, conocido como entrenamiento de la red, que producen un número positivo para las imágenes que contienen un perrito caliente y un número negativo para aquellos que no lo hacen es trivial. Debido a que hay muchos pesos en una red neuronal, lleva mucho tiempo encontrar los correctos para todas las neuronas de manera que todas las imágenes se clasifiquen correctamente. Simplemente hay demasiadas posibilidades. Además, dependiendo del conjunto de entrada, la red puede estar demasiado limitada al conjunto de datos específico, lo que significa que se centra demasiado estrechamente en el conjunto de datos y no puede generalizarse para reconocer imágenes fuera de él.

El proceso completo de formación de la red se basa en pasar los datos de entrada a través de la red varias veces. Cada pase toma la salida del anterior para hacer ajustes en pases futuros. La salida de cada pase se utiliza para proporcionar retroalimentación para mejorar el algoritmo a través de la retropropagación.

Una de las razones por las que la retropropagación tardó tanto en desarrollarse fue que la función requería que los ordenadores realizaran la multiplicación, lo que era bastante malo en las décadas de 1960 y 1970. A finales de la década de 1970, uno de los procesadores más potentes, el Intel 8086, podía calcular menos de un millón de instrucciones por segundo. * Para comparar,* el procesador que se ejecuta en el iPhone 12 es más de un millón de veces más potente que eso. *

APLICACIÓN GENERALIZADA

El aprendizaje profundo solo despegó en 2012, cuando Hinton y dos de sus estudiantes de Toronto demostraron que las redes neuronales profundas, entrenadas con retropropagación, vencieron a los sistemas de última generación en reconocimiento de imágenes casi a la mitad la tasa de error anterior. Debido a su trabajo y dedicación al campo, el nombre de Hinton se convirtió casi en sinónimo del campo del aprendizaje profundo. Ahora tiene más citas que los tres mejores investigadores de aprendizaje profundo combinados.

Después de este avance, el aprendizaje profundo comenzó a aplicarse en todas partes, con aplicaciones que incluían la clasificación de imágenes, la traducción del idioma y la comprensión del texto a voz, como lo usa Siri, por ejemplo. Los modelos de aprendizaje profundo pueden mejorar cualquier tarea que pueda abordarse mediante heurística, aquellas técnicas que se aplican para resolver algunas tareas que previamente fueron definidas por la experiencia o el pensamiento humano, incluidos juegos como Go, ajedrez y póquer, así como actividades como conducir coches. El aprendizaje profundo se utilizará cada vez más para mejorar el rendimiento de los sistemas informáticos con tareas como averiguar el orden en que los procesos deben ejecutarse o qué datos deben permanecer en una caché. Todas estas tareas pueden ser mucho más eficientes con los modelos de aprendizaje profundo. El almacenamiento será una gran aplicación de ello y, en mi opinión, el uso del aprendizaje profundo seguirá creciendo.

No es una coincidencia que el aprendizaje profundo despegue y funcionara mejor que la mayoría de los algoritmos de última generación: las redes neuronales multicapa tienen dos cualidades muy importantes. *

En primer lugar, expresan el tipo de funciones muy complicadas necesarias para resolver los problemas que tenemos que abordar. Por ejemplo, si quieres entender lo que está pasando con las imágenes, necesitas una función que recupere los píxeles y aplique una función complicada que los traduzca en texto o su representación al lenguaje humano. En segundo lugar, el aprendizaje profundo puede aprender con solo procesar datos, en lugar de necesitar una respuesta de retroalimentación. Estas dos cualidades lo hacen extremadamente poderoso, ya que muchos problemas, como la clasificación de imágenes, requieren muchos datos.

La razón por la que las redes neuronales profundas son tan buenas como son es que son equivalentes a los circuitos, y una neurona puede implementar fácilmente una función booleana. Por esa razón, una red lo suficientemente profunda puede simular un ordenador dado un número suficiente de pasos. Cada parte de una red neuronal simula la parte más simple de un procesador. Eso significa que las redes neuronales profundas son tan potentes como los ordenadores y, cuando se entrenan correctamente, pueden simular cualquier programa informático.

Actualmente, el aprendizaje profundo es un campo de batalla entre Google, Apple, Facebook y otras empresas de tecnología que tienen como objetivo satisfacer las necesidades de las personas en el mercado de consumo. Por ejemplo, Apple utiliza el aprendizaje profundo para mejorar sus modelos para Siri, y Google para su motor de recomendación en YouTube. Desde 2013, Hinton ha trabajado a tiempo parcial en Google en Mountain View, California, y Toronto, Canadá. Y, al momento de escribir este artículo en 2021, es el científico principal del equipo de Google Brain, posiblemente una de las organizaciones de investigación de IA más importantes del mundo.

Redes neuronales convolucionales

Hay muchos tipos de redes neuronales profundas, incluidas las redes neuronales convolucionales (CNN), las redes neuronales recurrentes (RNN) y las redes de memoria a corto plazo (LSTM), y cada una tiene propiedades diferentes. Por ejemplo, las redes neuronales recurrentes son redes neuronales profundas en las que las neuronas en las capas superiores se conectan de nuevo a las neuronas en las capas inferiores. Aquí, nos centraremos en las redes neuronales convolucionales, que son computacionalmente más eficientes y rápidas que la mayoría de las otras arquitecturas. * Son extremadamente relevantes, ya que se utilizan para la traducción de texto de última generación, el reconocimiento de imágenes y muchas otras tareas.

La primera vez que Yann LeCun revolucionó la inteligencia artificial fue un falso comienzo. * En 1995, había dedicado casi una década a lo que se consideraba una mala idea según muchos informáticos: que imitar algunas características del cerebro sería la mejor manera de mejorar los algoritmos de inteligencia artificial. Pero LeCun finalmente demostró que su enfoque podría producir algo sorprendentemente inteligente y útil.

En Bell Labs, LeCun trabajó en un software que simulaba cómo funciona el cerebro, más específicamente, cómo funciona la corteza visual. Bell Labs, una instalación de investigación propiedad de la entonces gigantesca AT&T, empleó a algunos de los eminentes informáticos de la época. Allí se desarrolló uno de los sistemas operativos Unix, que se convirtió en la base para Linux, macOS y Android. No solo eso, sino que también se desarrolló allí el transistor, la base de todos los chips de ordenador modernos, así como el láser y dos de los lenguajes de programación más utilizados hasta la fecha, C y C++. Era un centro de innovación, por lo que no fue una coincidencia que una de las arquitecturas de aprendizaje profundo más importantes naciera en el mismo laboratorio.

LeCun basó su trabajo en la investigación realizada por Kunihiko Fukushima, un investigador informático japonés. * Kunihiko creó un modelo de redes neuronales artificiales basado en cómo funciona la visión en el cerebro humano. La arquitectura se basó en dos tipos de células neuronales en el cerebro humano llamadas células simples y células complejas. Se encuentran en la corteza visual primaria, la parte del cerebro que procesa la información visual.

Las células simples son responsables de detectar características locales, como los bordes. Las células complejas agrupan los resultados que las células simples producen dentro de un área. Por ejemplo, una celda simple puede detectar un borde que puede representar una silla. Las células complejas agregan esa información informando al siguiente nivel superior lo que las células simples detectaron en la capa siguiente.

La arquitectura de una CNN se basa en un modelo en cascada de estos dos tipos de células, y se utiliza principalmente para tareas de reconocimiento de patrones. LeCun produjo el primer software que podía leer texto escrito a mano mirando muchos ejemplos diferentes usando este modelo de CNN. Con este trabajo, AT&T comenzó a vender las primeras máquinas capaces de leer escritura a mano en cheques. Para LeCun, esto marcó el comienzo de una nueva era en la que las redes neuronales se utilizarían en otros campos de la IA. Desafortunadamente, no iba a ser.

El mismo día que LeCun celebró el lanzamiento de máquinas bancarias que podían leer miles de cheques por hora, AT&T anunció que se estaba dividiendo en tres empresas diferentes, el resultado de una demanda antimonopolio del gobierno de los Estados Unidos. En ese momento, LeCun se convirtió en el jefe de investigación de un AT&T mucho más pequeño y fue dirigido a trabajar en otras cosas. En 2002, se fue y finalmente se convirtió en jefe del grupo de investigación de IA de Facebook.

LeCun continuó trabajando en redes neuronales, especialmente en redes neuronales convolucionales, y poco a poco el resto del mundo del aprendizaje automático se acercó a la tecnología. En 2012, algunos de sus estudiantes publicaron un artículo que demostraba el uso de CNN para clasificar los números de casas del mundo real mejor de lo que todos los algoritmos anteriores habían sido capaces de hacer. Desde entonces, las redes neuronales profundas han explotado en uso, y ahora la mayor parte de la investigación desarrollada en el aprendizaje automático se centra en el aprendizaje profundo. Las redes neuronales convolucionales se han extendido ampliamente y se han utilizado para vencer a la mayoría de los otros algoritmos para muchas aplicaciones, incluido el procesamiento del lenguaje natural y el reconocimiento de imágenes.

Los esfuerzos del equipo dieron sus frutos. En 2017, varias CNN procesaron todas las fotos subidas a Facebook. Uno de ellos identificó qué personas estaban en la imagen, y otro determinó si había objetos en la imagen. En ese momento, se subían alrededor de 800 millones de fotos al día, por lo que el rendimiento de las CNN era impresionante.

CÓMO FUNCIONAN LAS REDES NEURONALES CONVOLUNTIVAS

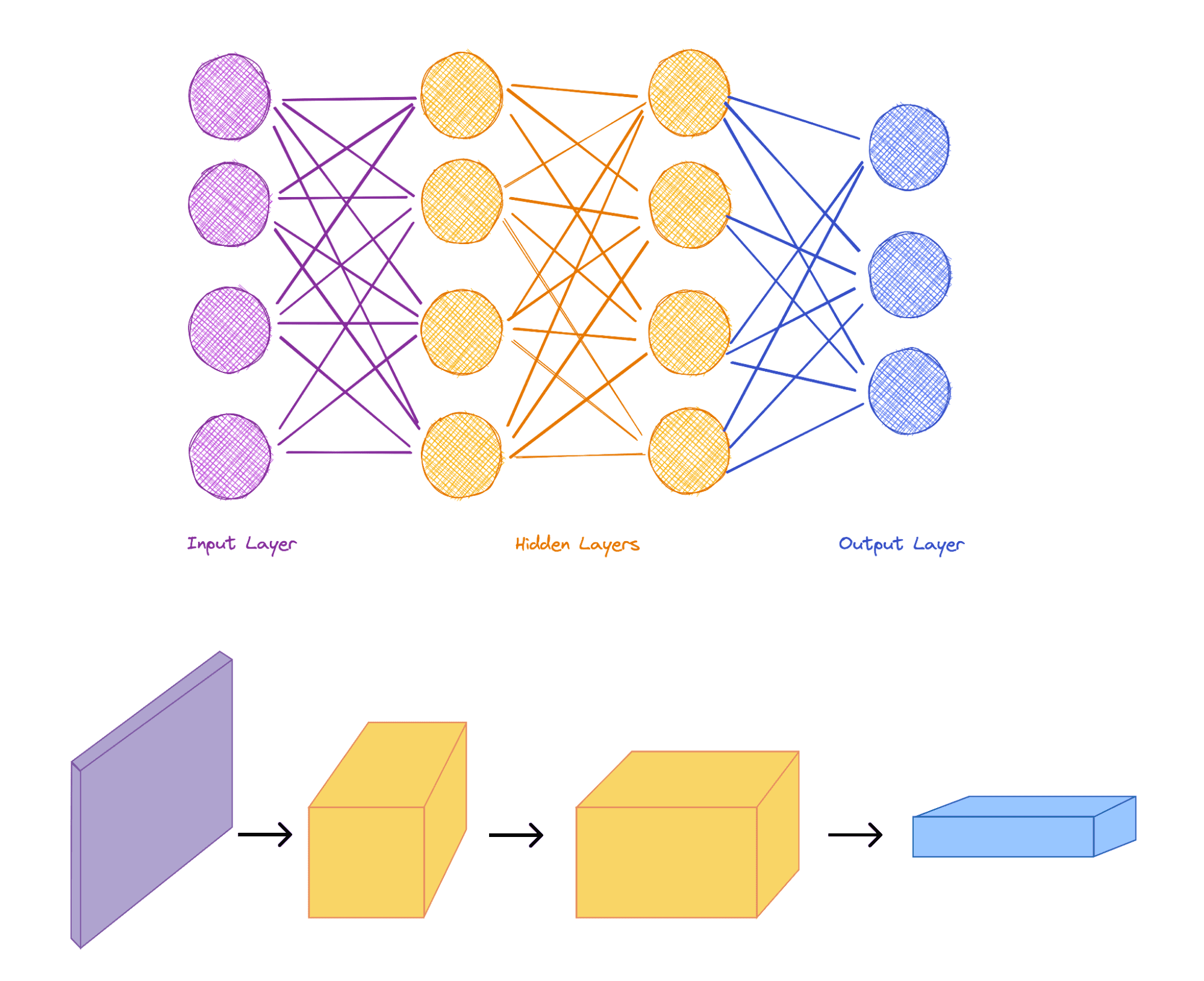

Una red neuronal convolucional (o CNN) es una red neuronal multicapa. Se nombra así porque contiene capas ocultas que realizan convoluciones. Una convolución es una función matemática que es la integral del producto de las dos funciones después de que una se invierte y se desplace. Para las imágenes, significa que estás ejecutando filtros en toda la imagen y produciendo imágenes con esos filtros.

En particular, la mayoría de las entradas a las CNN consisten en imágenes. *

En las capas que realizan la convolución, cada neurona camina a través de la imagen, multiplicando el número que representa cada píxel por el peso correspondiente en la neurona, generando una nueva imagen como salida.

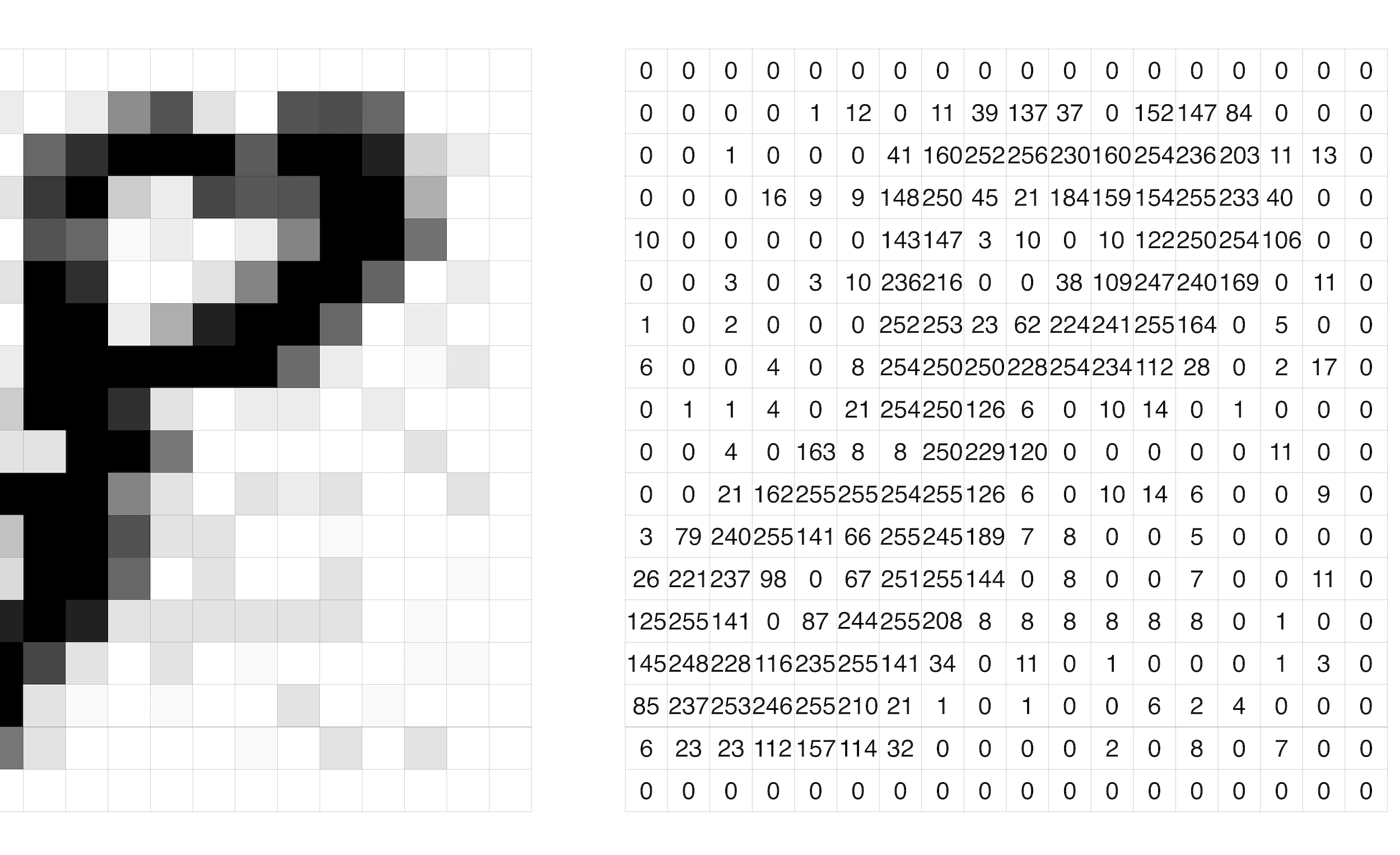

Examinemos cómo una red neuronal convolucional clasifica las imágenes. Primero, necesitamos hacer una imagen de algo con lo que una red neuronal pueda trabajar. Una imagen es solo datos. Representamos cada píxel de la imagen como un número; en una imagen en blanco y negro, esto puede indicar lo negro que es ese píxel. La siguiente figura representa el número 8. En esta representación, 0 es blanco y 255 es completamente negro. Cuanto más cerca esté el número de 255, más oscuro es el píxel.

Piensa en cada neurona como un filtro que atraviesa toda la imagen. Cada capa puede tener múltiples neuronas. La siguiente figura muestra dos neuronas caminando por toda la imagen. La neurona roja camina primero a través de la imagen, y la neurona verde hace lo mismo produciendo una nueva imagen resultante.

Las imágenes resultantes pueden ir directamente a la siguiente capa de la red neuronal y son procesadas por esas neuronas. Las imágenes procesadas en una capa también se pueden procesar mediante un método llamado agrupación antes de pasar a la siguiente capa. La función de agrupar es simplificar los resultados de las capas anteriores. Esto puede consistir en obtener el número máximo que los píxeles representan en una determinada región (o vecindario) o sumar los números en un vecindario. Esto se hace en varias capas. Cuando una neurona atraviesa una imagen, la siguiente capa produce una imagen más pequeña truncando los datos. Este proceso se repite una y otra vez a través de capas sucesivas. Al final, la CNN produce una lista de números o un solo número, dependiendo de la aplicación.

En función del resultado, la imagen se puede clasificar en función de lo que el sistema está buscando. Por ejemplo, si el número resultante es positivo, la imagen se puede clasificar como que contiene un perrito caliente, y si el número resultante es negativo, entonces la imagen se clasifica como que no contiene un perrito caliente. Pero esto supone que sabemos cómo se ve cada neurona, es decir, cómo se ve el filtro para cada capa. Al principio, las neuronas son completamente aleatorias, y mediante el uso de la técnica de retropropagación, las neuronas se actualizan de tal manera que producen el resultado deseado.

Una CNN está entrenada mostrándole muchas imágenes etiquetadas con sus resultados: las etiquetas. Este conjunto se llama datos de entrenamiento. La red neuronal actualiza sus pesos, en función de si clasifica las imágenes correctamente o no, utilizando los algoritmos de retropropagation. Después de la etapa de entrenamiento, la red neuronal resultante es la que se utiliza para clasificar nuevas imágenes. A pesar de que las CNN se crearon en función del funcionamiento de la corteza visual, también se pueden usar en el texto, por ejemplo. Para ello, las entradas se traducen a una matriz para que coincidan con el formato de una imagen.

Hay un error de que las redes neuronales profundas son una caja negra, es decir, que no hay forma de saber lo que están haciendo. La cosa es que no hay forma de determinar para cada entrada, ya sea imagen, sonido o texto, cuál es la salida resultante, o si la red la va a clasificar correctamente. Pero eso no significa que no haya forma de determinar lo que hace cada capa en la red aneural.

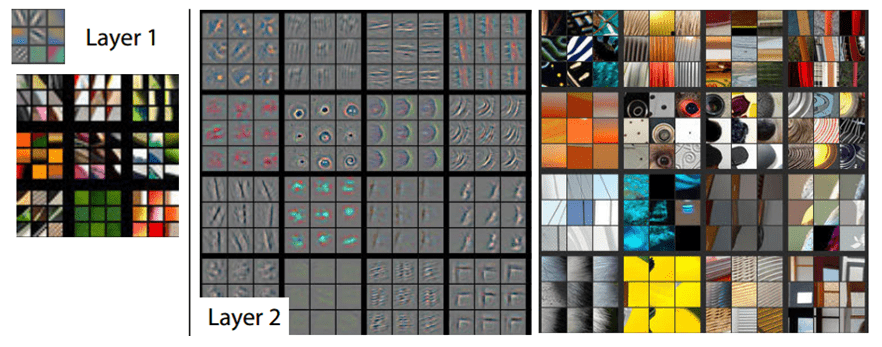

De hecho, para las CNN, ves cómo se ven los filtros y qué tipo de imágenes activan cada capa. Los pesos de cada neurona se pueden interpretar como imágenes. La figura anterior muestra los filtros en diferentes capas y también algunos ejemplos de imágenes que activan estas capas. Por ejemplo, en la primera capa de un CNN multicapa, los filtros, o pesos, para las neuronas parecen bordes. Eso significa que los filtros se activarán cuando se encuentren los bordes. La segunda capa de filtros muestra que los tipos de imágenes que activan son un poco más complejos, con ojos, curvas y otras formas. La tercera capa se activa con imágenes como ruedas, perfiles de personas, pájaros y caras. Eso significa que en cada capa de la red neuronal, se filtran imágenes más complejas. La primera capa filtra y pasa la información a la siguiente capa que dice si un área contiene bordes o no. Luego, la siguiente capa utiliza esa información, y a partir de los bordes detectados, intentará encontrar ruedas, etc. La última capa identificará las categorías que los humanos quieren conocer: identificará, por ejemplo, si la imagen contiene un gato, un perrito caliente o un humano.

Google Brain: La primera red neuronal a gran escala

El cerebro seguro que no funciona cuando alguien programa reglas.Geoffrey Hinton*

Google Brain comenzó como un proyecto de investigación entre los empleados de Google Jeff Dean y Greg Corrado y el profesor de Stanford Andrew Ng en 2011. * Pero Google Brain se convirtió en mucho más que un simple proyecto. Al adquirir empresas como DeepMind y personal clave de IA como Geoffrey Hinton, Google se ha convertido en un jugador formidable en el avance de este campo.

Uno de los primeros hitos clave de las redes neuronales profundas fue el resultado de la investigación inicial dirigida por Ng cuando decidió procesar vídeos de YouTube y alimentarlos a una red neuronal profunda. * En el transcurso de tres días, alimentó 10 millones de vídeos de YouTube* a 1.000 ordenadores con 16 núcleos cada uno, utilizando los 16.000 procesadores informáticos como red neuronal para aprender las características comunes de estos vídeos. Después de recibir una lista de 20 000 objetos diferentes, el sistema reconoció imágenes de gatos y alrededor de otros 3.000 objetos. Comenzó a reconocer el 16 % de los objetos sin ninguna aportación de los humanos.

El mismo software que reconoció a los gatos fue capaz de detectar caras con una precisión del 81,7 % y partes del cuerpo humano con una precisión del 76,7 %. * Con solo los datos, la red neural aprendió a reconocer imágenes. Era la primera vez que se utilizaba una cantidad tan masiva de datos para entrenar una red neuronal. Esta se convertiría en la práctica estándar en los próximos años. Los investigadores hicieron una observación interesante: “Vale la pena señalar que nuestra red sigue siendo pequeña en comparación con la corteza visual humana, que es106veces mayor en términos de número de neuronas y sinapsis”. *

DeepMind: Aprender de la experiencia

Demis Hassabis fue un niño prodigio en el ajedrez, alcanzando el estándar de Maestro a los 13 años, el segundo jugador mejor valorado en la categoría Mundial Sub-14, y también “cotó en la Serie Mundial de Póquer seis veces, incluso en el Evento Principal”. * En 1994 a los 18 años, comenzó su carrera en juegos de ordenador codiseñando y programando el clásico juego Theme Park, que vendió millones de copias. * Luego se convirtió en el jefe de desarrollo de IA para un juego icónico llamado Black & White en Lionhead Studios. Hassabis obtuvo su doctorado en neurociencia cognitiva en el University College de Londres en 2009.

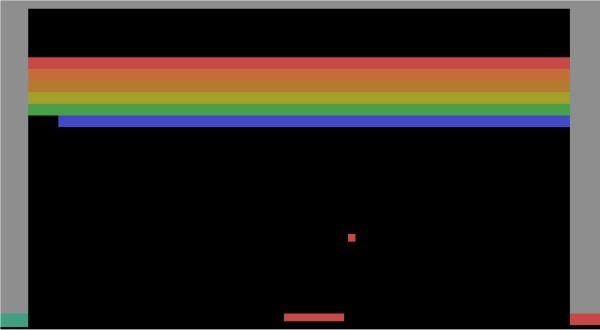

En 2010, Hassabis cofundó DeepMind en Londres con la misión de “resolver inteligencia” y luego usar esa inteligencia para “solstar todo lo demás”. Al principio de su desarrollo, DeepMind se centró en algoritmos que dominaban los juegos, empezando por los juegos desarrollados para Atari. * Google adquirió DeepMind en 2014 por 525 millones de dólares.

DEEPMIND JUEGA A ATARI

Para ayudar al programa a jugar, el equipo de DeepMind desarrolló un nuevo algoritmo, Deep Q-Network (DQN), que aprendió de la experiencia. Empezó a jugar juegos como el famoso juego Breakout, interpretando el vídeo y produciendo un comando en el joystick. Si el comando produjo una acción en la que el jugador obtuvo una puntuación, entonces el software de aprendizaje reforzó esa acción. La próxima vez que juegue, es probable que haga la misma acción. Es el aprendizaje de refuerzo, pero con una red neuronal profunda para determinar la calidad de una combinación de estado-acción. El DNN ayuda a determinar qué acción tomar dado el estado del juego, y el algoritmo aprende con el tiempo después de jugar algunos juegos y determinar las mejores acciones a tomar en cada punto.

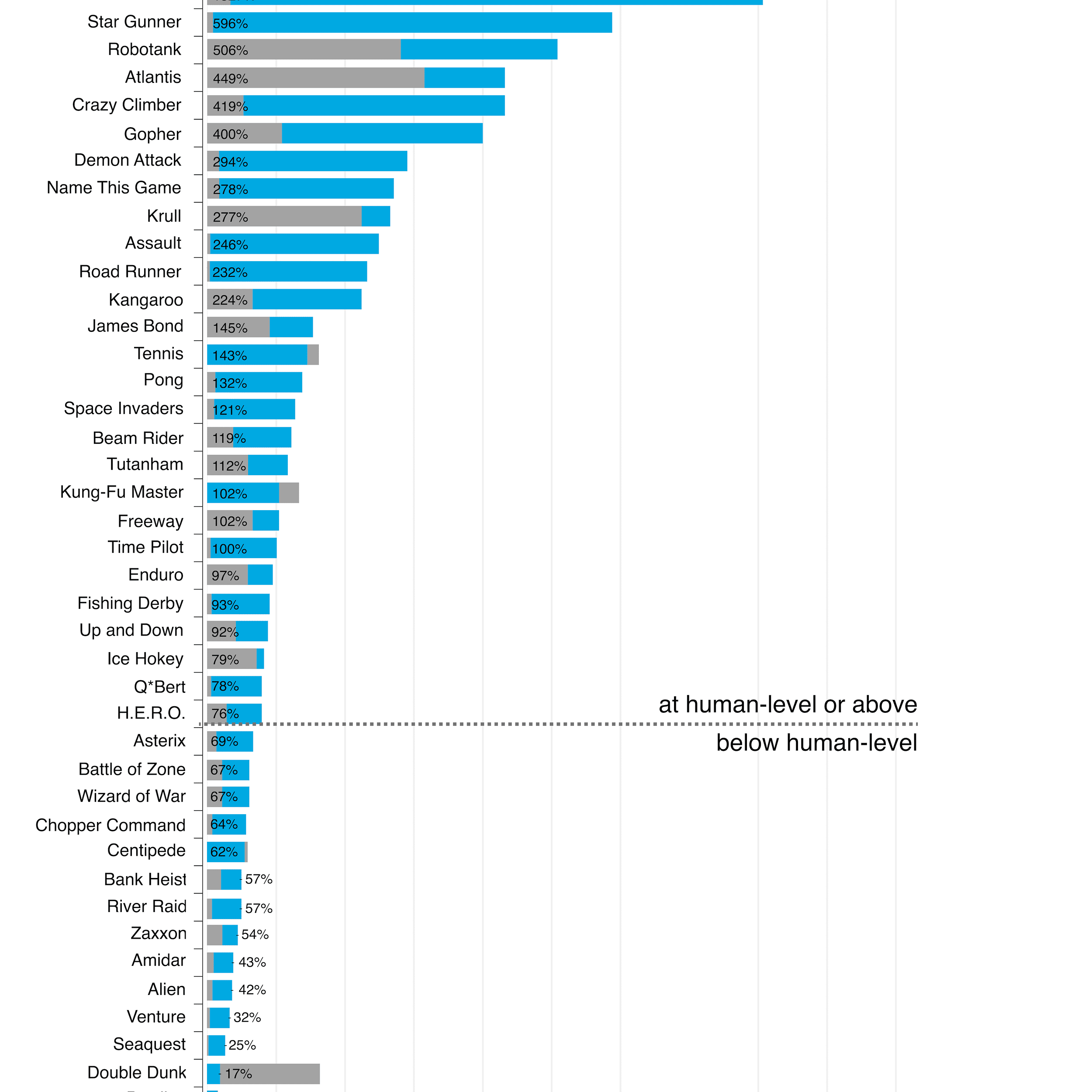

Por ejemplo, en el caso de Breakout,* después de jugar cien juegos, el software seguía siendo bastante malo y se perdía la pelota a menudo. Pero siguió jugando, y después de unas horas, 300 juegos, el software mejoró y jugó con la capacidad humana. Podría devolver la pelota y mantenerla viva durante mucho tiempo. Después de que lo dejaron jugar durante unas horas más, 500 juegos, se volvió mejor que el humano promedio, aprendiendo a hacer un truco llamado túnel, que implica enviar sistemáticamente la pelota a las paredes laterales para que rebote en la parte superior, requiriendo menos trabajo y ganando más recompensa. El mismo algoritmo de aprendizaje funcionó no solo en Breakout, sino también para la mayoría de los 57 juegos en los que DeepMind probó la técnica, alcanzando un nivel sobrehumano para la mayoría de ellos.

Sin embargo, el algoritmo de aprendizaje no funcionó bien para todos los juegos. Mirando al final de la lista, el software obtuvo una puntuación de cero en la Venganza de Montezuma. El software DQN de DeepMind no tiene éxito en este juego porque el jugador necesita entender conceptos de alto nivel que la gente aprende a lo largo de su vida. Por ejemplo, si miras el juego, sabes que estás controlando al personaje y que las escaleras son para escalar, las cuerdas son para balancearse, las llaves son probablemente buenas y el cráneo es probablemente malo.

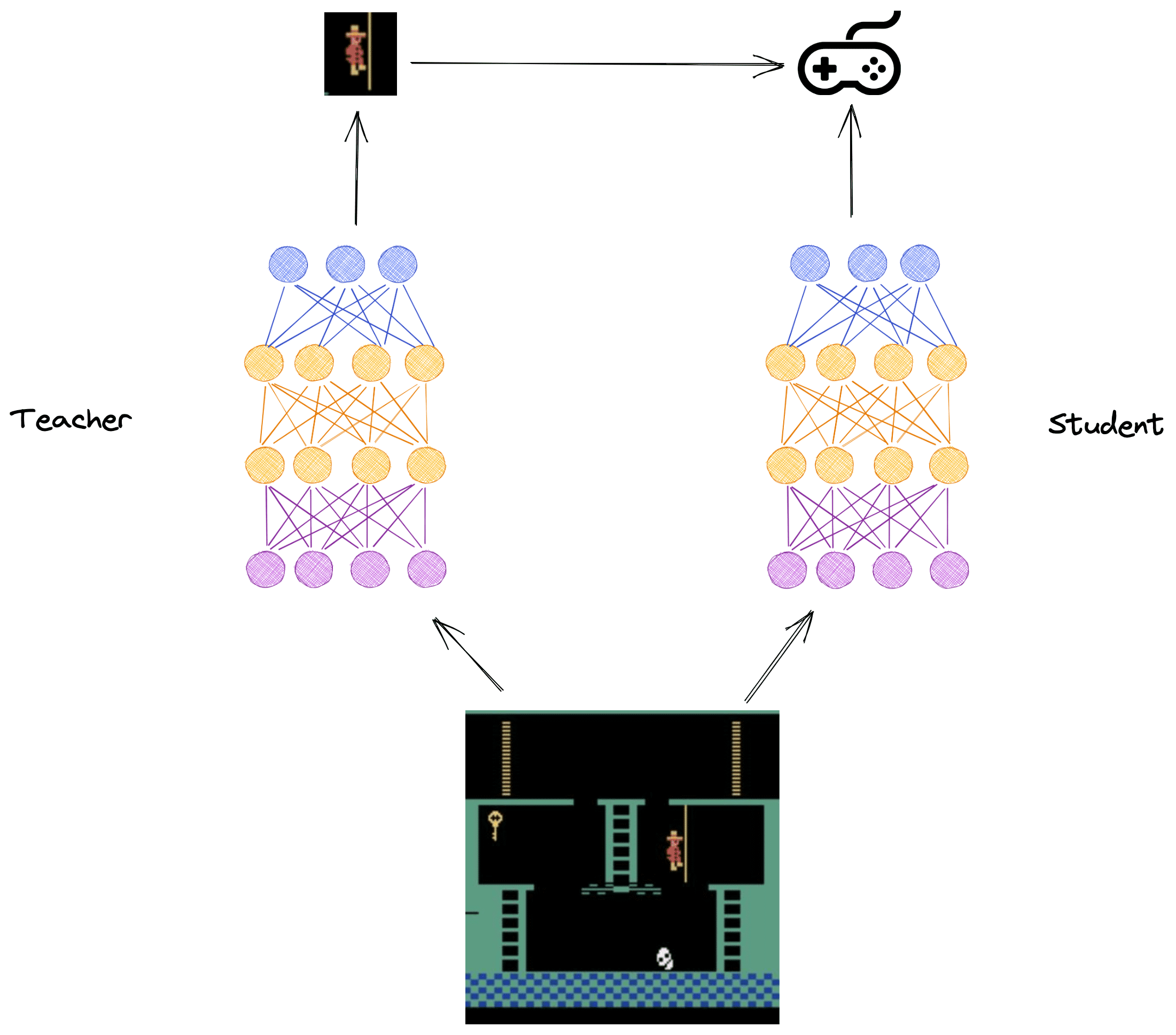

DeepMind mejoró el sistema dividiendo el problema en tareas más simples. Si el software pudiera resolver cosas como “saltar a través de la brecha”, “llevar a la escalera” y “pasar el cráneo y recoger la llave”, entonces podría resolver el juego y rendir bien en la tarea. Para atacar este problema, DeepMind creó dos redes neuronales: el profesor y el alumno. El profesor es responsable de aprender y producir estos subproblemas. El profesor envía estos subproblemas a otra red neuronal llamada el estudiante. El estudiante toma medidas en el juego e intenta maximizar la puntuación, pero también intenta hacer lo que el profesor le dice. A pesar de que fueron entrenados con los mismos datos que el antiguo algoritmo, además de alguna información adicional, la comunicación entre el profesor y el estudiante permitió que la estrategia y la comunicación surgieran con el tiempo, ayudando al agente a aprender a jugar el juego.

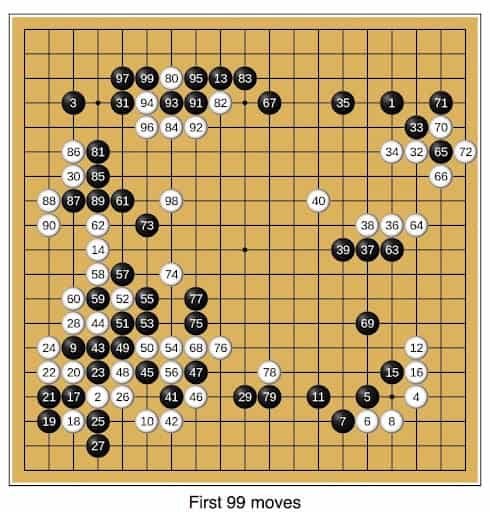

AlphaGo: Derrotando a los mejores jugadores de Go

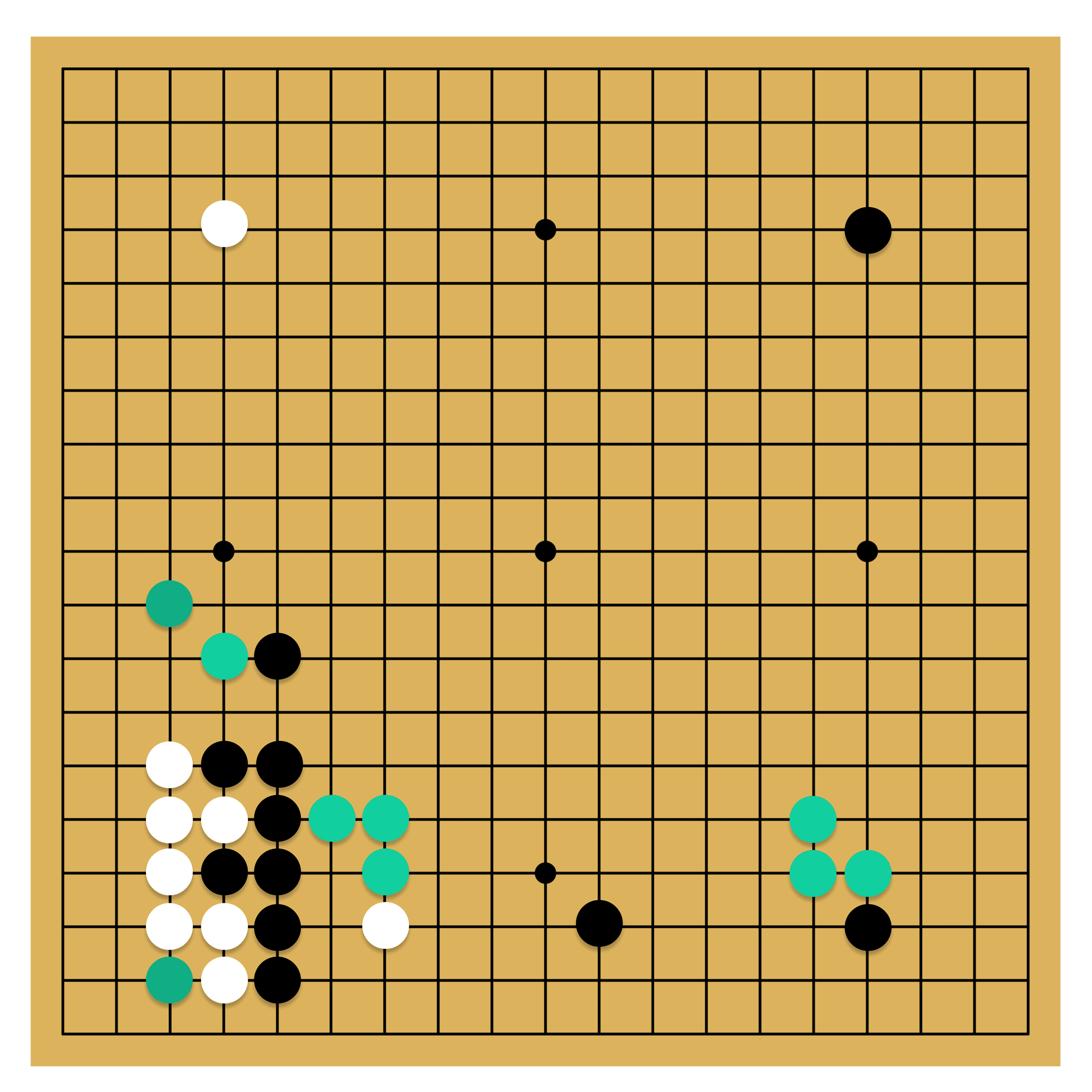

En la introducción, discutimos la competencia Go entre Lee Sedol y AlphaGo. Bueno, DeepMind desarrolló AlphaGo con el objetivo de jugar Go contra los Grandmasters. Octubre de 2015 fue la primera vez que el software venció a un humano en Go, un juego con10170posiciones, más posiciones posibles que el número de movimientos en el ajedrez o incluso el número total de átomos en el universo (alrededor1080). De hecho, si cada átomo del universo fuera un universo en sí, habría menos átomos que el número de posiciones en un juego Go.

En muchos países, como Corea del Sur y China, el Go se considera un juego nacional, como el fútbol y el baloncesto en los EE. UU., y estos países tienen muchos jugadores profesionales del Go, que entrenan a partir de los 6 años. * Si estos jugadores muestran promesa en el juego, cambian de una escuela normal a una escuela especial de Go donde juegan y estudian Go durante 12 horas al día, 7 días a la semana. Viven con su Go Master y otros hijos prodigios. Por lo tanto, es un asunto serio que un programa informático desafíe a estos jugadores.

Hay alrededor de 2.000 jugadores profesionales de Go en el mundo, junto con aproximadamente 40 millones de jugadores casuales. En una entrevista en el Google Campus,* Hassabis compartió: “Sabíamos que Go era mucho más difícil que el ajedrez”. Describe cómo pensó inicialmente en construir AlphaGo de la misma manera que se construyó Deep Blue, es decir, construyendo un sistema que hiciera una búsqueda de fuerza bruta con un conjunto de reglas hechas a mano.

Pero se dio cuenta de que esta técnica nunca funcionaría, ya que el juego es muy contextual, lo que significa que no había forma de crear un programa que pudiera determinar cómo una parte del tablero afectaría a otras partes debido al gran número de posibles estados. Al mismo tiempo, se dio cuenta de que si hubiera creado un algoritmo para vencer a los jugadores maestros en Go, entonces probablemente habría hecho un avance significativo en IA, más significativo que Deep Blue.

Go no solo es difícil porque el juego tiene un número astronómico de posibilidades, sino que para que un programa sea bueno jugando a Go, necesita determinar el mejor siguiente movimiento. Para averiguarlo, el software necesita determinar si una posición es buena o no. No puede jugar todas las posibilidades hasta el final porque había demasiadas. La sabiduría convencional pensó que era imposible determinar el valor de un determinado estado de juego para Go. Es mucho más simple hacer esto para el ajedrez. Por ejemplo, puede codificar cosas como la estructura de peones y la movilidad de las piezas, que son técnicas que los Grandes Maestros utilizan para determinar si una posición es buena o mala. En Go, por otro lado, todas las piezas son iguales. Incluso una sola piedra puede modificar el resultado del juego, por lo que cada una tiene un profundo impacto en el juego.

Lo que hace que Go sea aún más difícil es que es un juego constructivo en lugar de uno destructivo. En el ajedrez, empiezas con todas las piezas del tablero y te las quitas mientras juegas, lo que hace que el juego sea más sencillo. Cuanto más juegues, menos posibilidades habrá para los próximos movimientos. Go, sin embargo, comienza con un tablero vacío, y agregas piezas, lo que hace que sea más difícil de analizar. En el ajedrez, si analizas un juego intermedio complicado, puedes evaluar la situación actual, y eso lo dice todo. Para analizar un juego intermedio en Go, tienes que proyectar en el futuro para examinar la situación actual del tablero, lo que hace que sea mucho más difícil de analizar. En realidad, Go se trata más de la intuición y el instinto que del cálculo como el ajedrez.

Al describir el algoritmo que AlphaGo produjo, Hassabis dijo que no se limita a regurgitar las ideas humanas y las copia. Realmente viene con ideas originales. Según él, Go es un arte objetivo porque a cualquiera se le ocurre un movimiento original, pero se puede medir si ese movimiento o idea fue fundamental para ganar el juego. A pesar de que Go se ha jugado a nivel profesional durante 3.000 años, AlphaGo creó nuevas técnicas e influyó directamente en la forma en que la gente jugaba porque AlphaGo era estratégico y parecía humano.

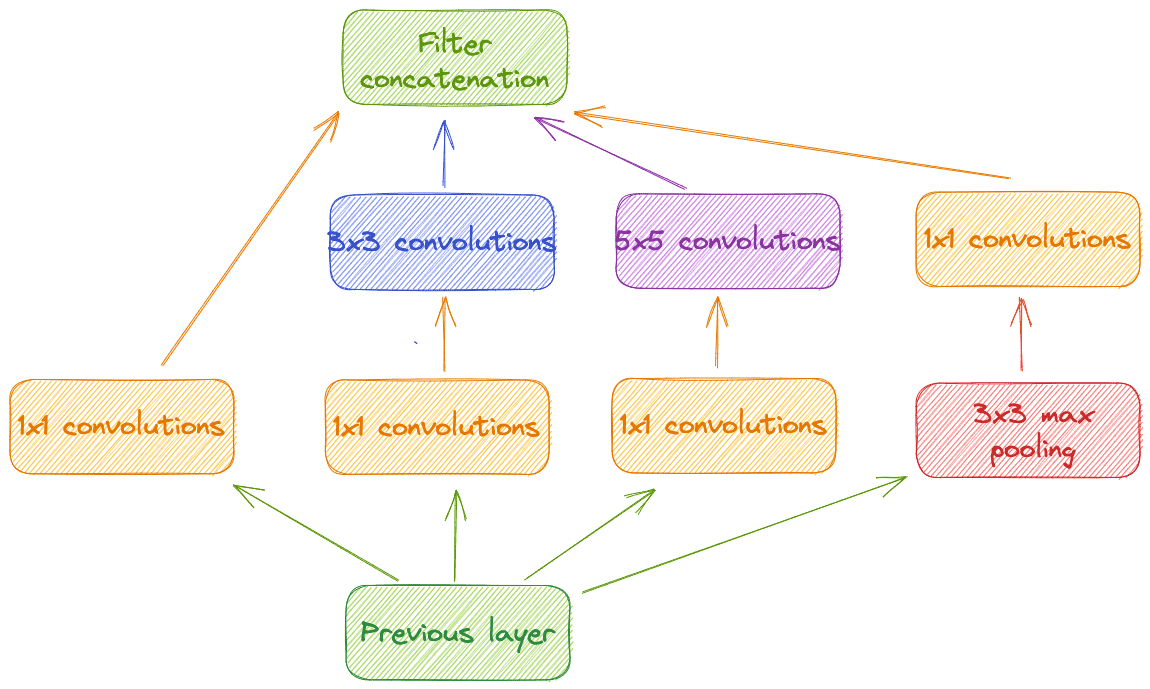

EL FUNCIONAMIENTO DE ALPHAGO

DeepMind desarrolló AlphaGo principalmente con dos redes neuronales. * El primero, la Red de Políticas, calcula la probabilidad del siguiente movimiento para un jugador profesional dado el estado de la junta. En lugar de buscar los próximos 200 movimientos, la Red de Políticas solo busca los próximos cinco a diez. Al hacerlo, reduce el número de posiciones que AlphaGo tiene que buscar para encontrar cuál es el siguiente mejor movimiento.

Inicialmente, AlphaGo se entrenó utilizando alrededor de 100.000 juegos de Go de Internet. Pero una vez que pudo reducir la búsqueda del siguiente movimiento, AlphaGo jugó contra sí mismo millones de veces y mejoró a través del aprendizaje de refuerzo. El programa aprendió a través de sus propios errores. Si ganara, sería más probable que hiciera esos movimientos en el próximo juego. Con esa información, creó su propia base de datos de millones de juegos del sistema jugando contra sí mismo.

Luego, DeepMind entrenó una segunda red neuronal, la Value Network, que calculó la probabilidad de que un jugador ganara en función del estado del tablero. Se produce 1 para la victoria negra, 0 para el blanco y 0,5 para un empate. Juntas, estas dos redes convirtieron lo que parecía un problema intratable en uno manejable. Transformaron el problema de jugar a Go en un problema similar de resolver un juego de ajedrez. La Red de Políticas proporciona los siguientes diez movimientos probables, y la Red de Valor da la puntuación de un estado de la junta. Dadas estas dos redes, el algoritmo para encontrar los mejores movimientos, la búsqueda del árbol de Monte Carlo, similar a la utilizada para jugar al ajedrez, es decir, la búsqueda mínima máxima descrita anteriormente, utiliza las probabilidades para explorar el espacio de posibilidades.

EL PARTIDO

AlphaGo jugó como el mejor jugador del mundo, Lee Sedol, una leyenda del juego que había ganado más de 18 títulos mundiales. En juego estaba en 1 millón de dólares de recompensa.

AlphaGo jugó movimientos inimaginables, cambiando la forma en que la gente jugaría a Go en los próximos años. El campeón europeo, Fen Hui, le dijo a Hassabis que su mente estaba libre de los grilletes de la tradición después de ver las innovadoras obras de AlphaGo; ahora consideraba pensamientos impensables y no estaba limitado por la sabiduría recibida que lo había ligado durante décadas.

“Estaba profundamente impresionado”, dijo Ke Jie a través de un intérprete después del partido. Refiriéndose a un tipo de movimiento que implica dividir las piedras de un oponente, agregó: “Hubo un corte que me sorprendió bastante, porque era un movimiento que nunca ocurriría en un partido de Go de humano a humano”. * Jie, el actual jugador de Go número uno del mundo, declaró: “La humanidad ha jugado al Go durante miles de años y, sin embargo, como nos ha demostrado la IA, ni siquiera hemos rayado la superficie”. Continuó: “La unión de los jugadores humanos y informáticos marcará el comienzo de una nueva era. Juntos, el hombre y la IA pueden encontrar la verdad de Go”. *

ALPHAGO ZERO

El equipo de DeepMind no se detuvo después de ganar contra el mejor jugador del mundo. Decidieron mejorar el software, por lo que fusionaron las dos redes de neuronas profundas, las redes de políticas y valor, creando AlphaGo Zero. “La fusión de estas funciones en una sola red neuronal hizo que el algoritmo fuera más fuerte y mucho más eficiente”, dijo David Silver, el investigador principal de AlphaGo. AlphaGo Zero eliminó muchas redundancias entre las redes de dos neuronas. La probabilidad de añadir una pieza a una posición (Policy Network) contiene la información de quién podría ganar el juego (Value Network). Si solo hay una posición para que el jugador coloque una pieza, podría significar que el jugador está acorralado y tiene pocas posibilidades de ganar. O, si el jugador puede colocar una pieza en cualquier lugar del tablero, eso probablemente significa que el jugador está ganando porque no importa dónde coloque la siguiente pieza en el tablero. Y debido a que la fusión de las redes eliminó estas redundancias, la red neuronal resultante era más pequeña, lo que la hacía mucho menos compleja y, por lo tanto, más eficiente. La red tenía menos pesos y requería menos entrenamiento para averiguarlo. “Todavía requería una gran cantidad de potencia informática: cuatro de los chips especializados llamados unidades de procesamiento de tensores (TPU), que Hassabis estimó en 25 millones de dólares de hardware. Pero sus predecesores usaron diez veces ese número. También se entrenó en días en lugar de meses. La implicación es que “los algoritmos importan mucho más que la informática o los datos disponibles”, dijo Silver. *

Los críticos señalan que lo que hace AlphaGo en realidad no es aprender porque si hicieras que el agente jugara el juego con las mismas reglas pero cambiaras el color de las piezas, entonces el programa estaría confundido y funcionaría terriblemente. Los humanos pueden jugar bien si hay cambios menores en el juego. Pero eso se puede resolver entrenando el software con diferentes juegos, así como con diferentes piezas de colores. DeepMind hizo que sus algoritmos se generalizaran para otros juegos como Atari utilizando una técnica llamada consolidación sináptica. Sin este nuevo método, cuando un agente aprende a jugar el juego por primera vez, el agente satura las conexiones neuronales con el conocimiento sobre cómo jugar el primer juego. Luego, cuando el agente comienza a aprender a jugar una variación del juego o un juego diferente, todas las conexiones se destruyen para aprender a jugar el segundo juego, produciendo un olvido catastrófico.

Si una red neuronal simple está entrenada para jugar al Pong controlando la paleta a la izquierda, entonces después de que aprenda a jugar el juego, el agente siempre ganará, obteniendo una puntuación de 20 a 0. Si cambias el color de la paleta de verde a negro, el agente sigue controlando la misma paleta, pero siempre perderá la pelota. Termina perdiendo 20 a 0, mostrando un fracaso catastrófico. DeepMind resolvió esto inspirándose en cómo funciona el cerebro de un ratón y, presumiblemente, también de cómo funciona el cerebro humano. En el cerebro, hay un proceso llamado consolidación sináptica. Es el proceso en el que el cerebro solo protege las conexiones neuronales que se forman cuando se aprende una nueva habilidad en particular.

Inspirándose en la biología, DeepMind desarrolló un algoritmo que hace lo mismo. Después de jugar un juego, identifica y protege solo las conexiones neuronales que son las más importantes para ese juego. Eso significa que cada vez que el agente comienza a jugar un nuevo juego, las neuronas sobrante se pueden usar para aprender un nuevo juego y, al mismo tiempo, se conserva el conocimiento que se utilizó para jugar el juego antiguo, eliminando el olvido catastrófico. Con esta técnica, DeepMind demostró que los agentes podían aprender a jugar diez juegos de Atari sin olvidar cómo jugar a los viejos a nivel sobrehumano. La misma técnica se puede utilizar para hacer que AlphaGo aprenda a jugar diferentes variaciones del juego Go.

OpenAI

OpenAI, un instituto de investigación iniciado por multimillonarios de tecnología como Elon Musk, Sam Altman, Peter Thiel y Reid Hoffman, tuvo un nuevo desafío. OpenAI se inició para avanzar en la inteligencia artificial y evitar que la tecnología se vuelva peligrosa. En 2016, dirigidos por el CTO y cofundador, Greg Brockman, comenzaron a buscar en Twitch, una comunidad de juegos por Internet, para encontrar los juegos más populares que tenían una interfaz con la que un programa de software pudiera interactuar y que se ejecutaban en el sistema operativo Linux. Eligieron Dota 2. La idea era hacer un programa de software que pudiera vencer al mejor jugador humano, así como a los mejores equipos del mundo, un objetivo elevado. Por un amplio margen, Dota 2 sería el juego más difícil en el que la IA vencería a los humanos.

A primera vista, Dota 2 puede parecer menos cerebral que Go y ajedrez debido a sus orcos y criaturas. El juego, sin embargo, es mucho más difícil que esos juegos de estrategia porque el tablero en sí y el número de movimientos posibles son mucho mayores que los juegos anteriores. No solo eso, sino que hay alrededor de 110 héroes, y cada uno tiene al menos cuatro movimientos. El número promedio de movimientos posibles por turno para el ajedrez es de alrededor de 20 y para Go, alrededor de 200. Dota 2 tiene un promedio de 1000 movimientos posibles por cada octavo de segundo, y el partido promedio dura alrededor de 45 minutos. Dota 2 no es una broma.

Su primer desafío fue vencer a los mejores humanos en un partido individual. Eso significaba que una máquina solo jugaba contra un solo humano que controlaba a su propia criatura. Esa es una hazaña mucho más fácil que un ordenador jugando contra un equipo de cinco humanos (5v5) porque jugar uno a uno es un juego más estratégico y un desafío mucho más difícil para los humanos. Con un equipo, un jugador podría defenderse y otro atacar al mismo tiempo, por ejemplo.

Para vencer a los mejores humanos en este juego, OpenAI desarrolló un sistema llamado Rapid. En este sistema, los agentes de IA jugaron contra sí mismos millones de veces al día, utilizando el aprendizaje de refuerzo para entrenar una red neuronal multicapa, una LSTM específicamente, para que pudiera aprender los mejores movimientos con el tiempo. Con todo este entrenamiento, en agosto del año siguiente, los agentes de OpenAI derrotaron a los jugadores de bestDota 2 en partidos uno a uno y permanecieron invictos contra ellos.

OpenAI se centró en la versión más difícil del juego: 5v5. El nuevo agente se llamó acertadamente OpenAI Five. Para entrenarlo, OpenAI volvió a utilizar su sistema Rapid, jugando el equivalente a 180 años de Dota 2 al día. Corrió sus simulaciones utilizando el equivalente a 128 000 procesadores informáticos y 256 GPU. La capacitación se centró en actualizar una enorme red de memoria a corto plazo con los juegos y aplicar el aprendizaje de refuerzo. OpenAI Five recibe una cantidad impresionante de información: 20 000 números que representan el estado de la junta y lo que los jugadores están haciendo en un momento dado. *

En enero de 2018, OpenAI comenzó a probar su software contra bots, y su agente de IA ya estaba ganando contra algunos de ellos. En agosto del mismo año, OpenAI Five venció a algunos de los mejores equipos humanos en un partido de 5 contra 5, aunque con algunas limitaciones a las reglas.

Por lo tanto, el equipo de OpenAI decidió jugar contra el mejor equipo del mundo en la mayor competición de Dota 2, The International, en Vancouver, Canadá. A finales de agosto, los agentes de IA jugaron contra el mejor equipo del mundo frente a una gran audiencia en un estadio, y cientos de miles de personas vieron el partido a través de la transmisión. En un partido muy competitivo, perdió contra el equipo humano. Pero en menos de un año, en abril de 2019, OpenAI Five venció al mejor equipo del mundo en dos partidos consecutivos en el International. *

Software 2.0

Los lenguajes informáticos del futuro estarán más preocupados por los objetivos y menos por los procedimientos especificados por el programador.Marvin Minsky*

El paradigma Software 2.0 comenzó con el desarrollo del primer lenguaje de aprendizaje profundo, TensorFlow.

Al crear redes neuronales profundas, los programadores escriben solo unas pocas líneas de código y hacen que la red neuronal aprenda el programa en sí en lugar de escribir código a mano. Este nuevo estilo de codificación se llama Software 2.0 porque antes del auge del aprendizaje profundo, la mayoría de los programas de IA estaban escritos a mano en lenguajes de programación como Python y JavaScript. Los humanos escribieron cada línea de código y también determinaron todas las reglas del programa. En contraste, con la aparición de técnicas de aprendizaje profundo, la nueva forma en que los codificadores programan estos sistemas es especificando el objetivo del programa, como ganar un juego Go, o proporcionando datos con la entrada y salida adecuadas, como alimentar a las imágenes del algoritmo de gatos con etiquetas de “gato” y otras imágenes sin gatos con etiquetas “no gato”.

Basado en el objetivo, el programador escribe el esqueleto del programa definiendo la(s) arquitectura(es) de la red neuronal. Luego, el programador utiliza el hardware del ordenador para encontrar la red neuronal exacta que mejor realiza el objetivo especificado y le da datos para entrenar a la red neuronal. Con el software tradicional, Software 1.0, la mayoría de los programas se almacenan como código escrito por un programador que puede abarcar entre miles y mil millones de líneas de código. Por ejemplo, toda la base de código de Google tiene alrededor de dos mil millones de líneas de código. * Pero en el nuevo paradigma, el programa se almacena en la memoria como los pesos de la arquitectura neuronal con pocas líneas de código escritas por programadores. Hay desventajas en este nuevo enfoque: los desarrolladores de software a veces tienen que elegir entre usar software que entienden, pero que solo funciona el 90 % del tiempo, o un programa que funciona bien en el 99 % de los casos, pero no se entiende tan bien.

TENSORFLOW

Algunos lenguajes se crearon solo para escribir Software 2.0, es decir, lenguajes de programación para ayudar a construir, entrenar y ejecutar estas redes neuronales. El más conocido y ampliamente utilizado es TensorFlow. Desarrollado por Google y lanzado internamente en 2015, ahora alimenta productos de Google como Smart Reply y Google Photos, pero también se puso a disposición de desarrolladores externos. Ahora es más popular que el sistema operativo Linux por algunas métricas. Fue ampliamente utilizado por desarrolladores, nuevas empresas y otras grandes empresas para todo tipo de tareas de aprendizaje automático, incluida la traducción del inglés al chino y la lectura de textos escritos a mano. TensorFlow se utiliza para crear, entrenar e implementar una red neuronal para realizar diferentes tareas. Pero para entrenar la red resultante, el desarrollador debe alimentarla con datos y definir el objetivo para el que la red neuronal optimiza. Esto es tan importante como definir la red neuronal.

LA IMPORTANCIA DE LOS BUENOS DATOS DE ENTRENAMIENTO

Debido a que una gran parte del programa son los datos que se le suministran, existe una creciente preocupación de que los conjuntos de datos utilizados para estas redes representen todos los posibles escenarios en los que el programa pueda encontrarse. Los datos se han vuelto esenciales para que el software funcione como se esperaba. Uno de los problemas es que a veces los datos pueden no representar todos los casos de uso que un programador quiere cubrir al desarrollar la red neural. Y es posible que los datos no representen los escenarios más importantes. Por lo tanto, el tamaño y la variedad del conjunto de datos se han vuelto cada vez más importantes para que las redes neuronales funcionen como se esperaba.

Por ejemplo, digamos que quieres una red neuronal que cree una caja delimitadora alrededor de los coches en la carretera. Los datos deben cubrir todos los casos. Si hay un reflejo de un coche en un autobús, entonces los datos no deberían tener etiquetado como un coche en la carretera. Para que la red neuronal aprenda eso, el programador necesita tener suficientes datos que representen este caso de uso. O digamos que hay cinco coches en un portacoches. ¿Debería el software crear una caja delimitadora para cada uno de los automóviles o solo para el portador del automóvil? De cualquier manera, el programador necesita suficientes ejemplos de estos casos en el conjunto de datos.

Otro ejemplo es si los datos de entrenamiento del coche vienen con muchos datos recopilados en ciertas condiciones de iluminación o con un vehículo específico. Entonces, si esos mismos algoritmos se encuentran con un vehículo con una forma diferente o con una iluminación diferente, el algoritmo puede comportarse de manera diferente. Un ejemplo que le sucedió a Tesla fue cuando el software de conducción autónoma estaba activado y el software no se dio cuenta del remolque frente al coche. El lado blanco del remolque del tractor contra un cielo brillantemente iluminado era difícil de detectar. El accidente provocó la muerte del conductor. *

El etiquetado, es decir, crear el conjunto de datos y anotarlo con la información correcta, es un proceso iterativo importante que requiere tiempo y experiencia para que funcione correctamente. Los datos deben capturarse y limpiarse. No es algo hecho una vez y luego está completo. Más bien, es algo que evoluciona.

EL GRANJERO JAPONÉS DE PEPINOS

TensorFlow no solo ha sido utilizado por desarrolladores, nuevas empresas y grandes corporaciones, sino también por individuos. Una historia sorprendente es de un agricultor japonés de pepinos. Un ingeniero automotriz, Makoto Koike, ayudó a sus padres a clasificar los pepinos por tamaño, forma, color y otros atributos en su pequeña granja familiar en la pequeña ciudad de Kosai. Durante años, clasificaron sus pepinillos manualmente. Sucede que los pepinos en Japón tienen precios diferentes dependiendo de sus características. Por ejemplo, los pepinos más coloridos y los que tienen muchas garradores son más caros que otros. Los agricultores dejan de lado los pepinos que son más caros para que se les pague de manera justa por su cosecha.

El problema es que es difícil encontrar trabajadores para clasificarlos durante la temporada de cosecha, y no hay máquinas que se vendan a los pequeños agricultores para ayudar con la clasificación de pepinos. Son demasiado caros o no proporcionan las capacidades que las pequeñas granjas necesitan. Los padres de Makoto separaron los pepinos a mano, lo cual es tan difícil como cultivarlos y lleva meses. La madre de Makoto solía pasar ocho horas al día clasificándolos. Así que, en 2015, después de ver cómo AlphaGo derrotó a los mejores jugadores de Go, Makoto tuvo una idea. Decidió usar el mismo lenguaje de programación, TensorFlow, para desarrollar una máquina de clasificación de pepinos.

Para ello, tomó 7.000 fotos de pepinos cosechados en la granja de su familia. Luego, etiquetó las imágenes con las propiedades que tenía cada pepino, añadiendo información sobre su color, forma, tamaño y si contenían pinchos. Utilizó una arquitectura de red neuronal popular y la entrenó con las fotos que tomó. En ese momento, Makoto no entrenó la red neuronal con los servidores informáticos que Google ofrecía porque cobraban por el tiempo utilizado. En su lugar, entrenó la red usando su ordenador de escritorio de baja potencia. Por lo tanto, para entrenar su herramienta de manera oportuna, convirtió las imágenes a un tamaño más pequeño de 80×80 píxeles. Cuanto más pequeño sea el tamaño de las imágenes, más rápido será entrenar la red neuronal porque la red neuronal también es más pequeña. Pero incluso con la baja resolución, le llevó tres días entrenar su red neuronal.

Después de todo el trabajo, “cuando hice una validación con las imágenes de prueba, la precisión de reconocimiento superó el 95 %. Pero si aplicas el sistema con casos de uso real, la precisión cae a alrededor del 70 %. Sospecho que el modelo de red neuronal tiene el problema de “sobreajuste”, declaró Makoto. *

El sobreajuste, también llamado sobreentrenamiento, es el fenómeno cuando se crea un modelo de aprendizaje automático y solo funciona para los datos de entrenamiento.

Makoto creó una máquina que pudo ayudar a sus padres a clasificar los pepinos en diferentes formas, colores, longitud y nivel de distorsión. No pudo averiguar si los pepinos tenían muchas pinchatas o no debido a las imágenes de baja resolución utilizadas para el entrenamiento. Pero la máquina resultante resultó ser muy útil para su familia y cortó el tiempo que pasaron clasificando manualmente sus productos.

La misma tecnología construida por una de las empresas más grandes del mundo y utilizada para alimentar sus muchos productos también fue utilizada por un pequeño agricultor del otro lado del mundo. TensorFlow democratizó el acceso para que muchas personas pudieran desarrollar sus propios modelos de aprendizaje profundo. No será sorprendente encontrar muchos más “Makotos” por ahí.

ERRORES 2.0

En el Software 1.0, los problemas, llamados errores, ocaieron principalmente porque una persona escribía una lógica que no tenía en cuenta los casos de borde ni manejaba todos los escenarios posibles. Pero en la pila de Software 2.0, los errores son muy diferentes porque los datos pueden confundir a la red neuronal.

Un ejemplo de tal error fue cuando la autocorrección para iOS comenzó a usar un carácter extraño “#?” para reemplazar la palabra “yo” al enviar un mensaje. El sistema operativo corrigió automáticamente por error la ortografía de I porque, en algún momento, los datos que recibió le enseñaron a hacerlo. El modelo aprendió que “#?” era la ortografía correcta de acuerdo con los datos. Tan pronto como alguien envió “yo”, el modelo pensó que era importante arreglarlo y reemplazarlo en todas partes. El error se propagó como un virus, llegando a millones de iPhones. Dado lo rápidos e importantes que pueden ser estos errores, es extremadamente importante que los datos y los programas estén bien probados, asegurándose de que estos casos de borde no hagan que los programas fallen.

Duelo de redes neuronales

Lo que no puedo crear, no lo entiendo.Richard Feynman*

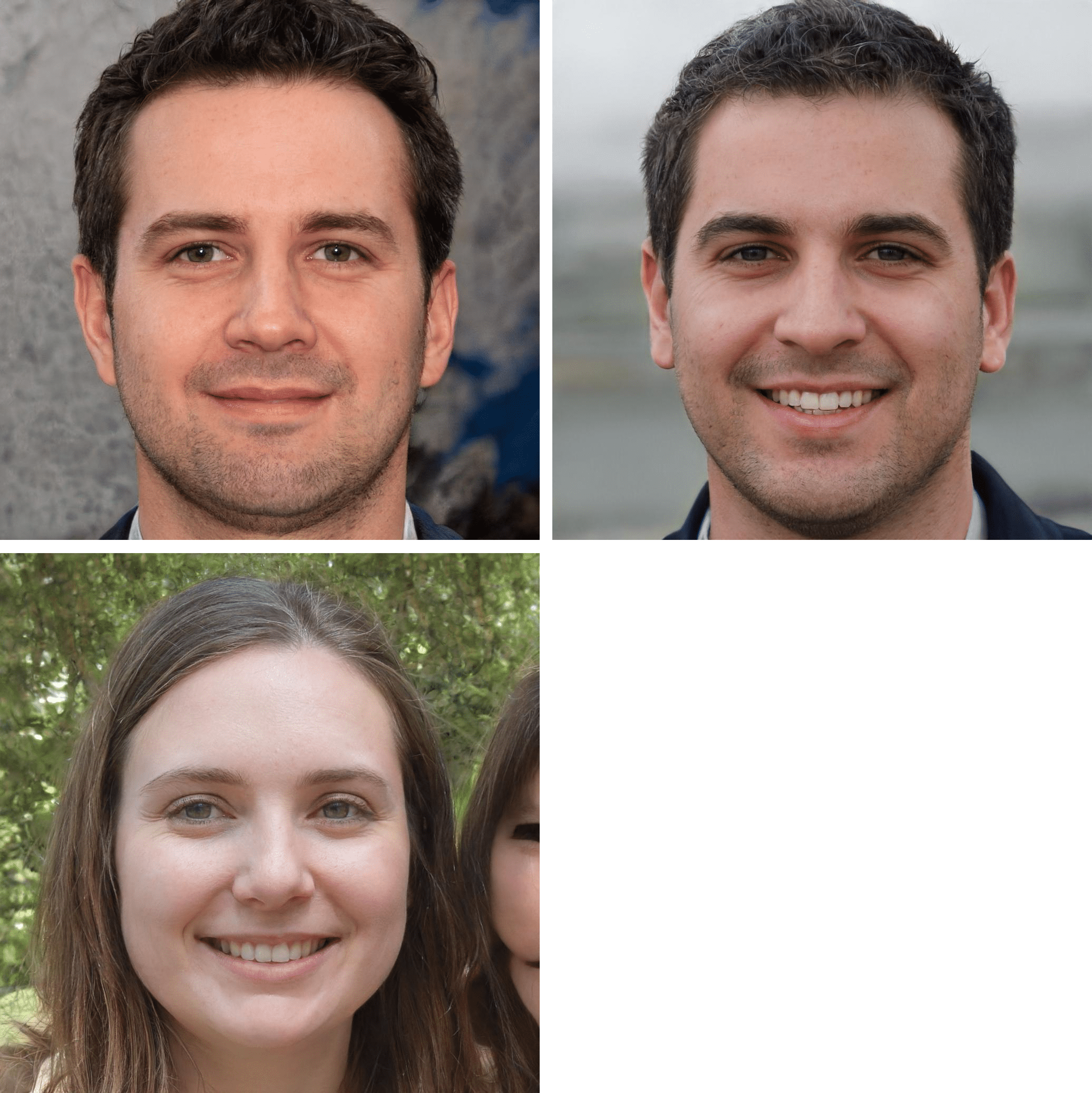

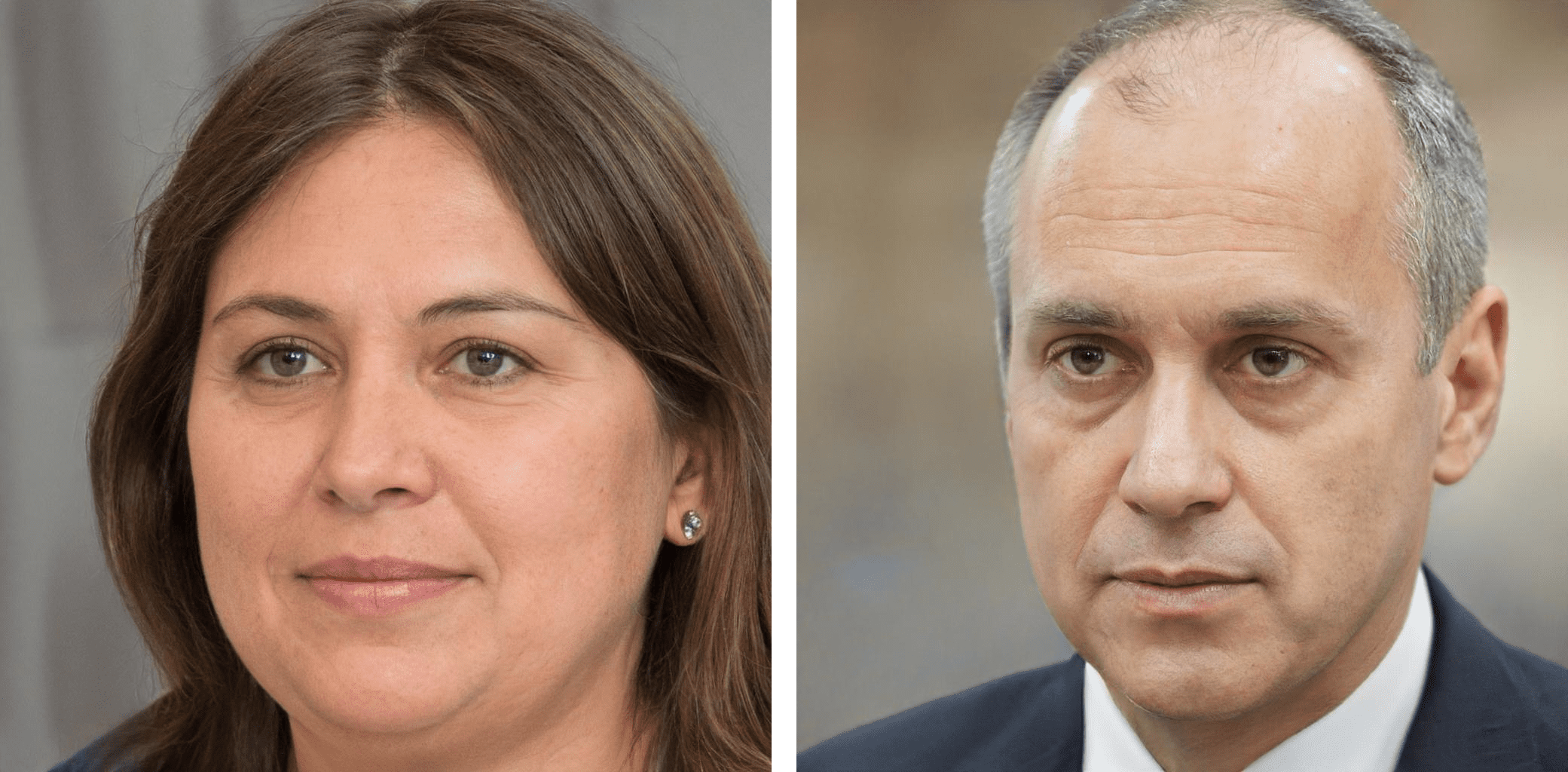

Uno de los desarrollos más importantes de la última década en el aprendizaje profundo son las redes adversarias generativas, desarrolladas por Ian Goodfellow. Esta nueva tecnología también se puede utilizar para malas intenciones, como para generar imágenes y vídeos falsos.

REDES ADVERSARIAS GENERATIVAS

GAN, o red adversaria generativa, es una clase de marco de aprendizaje automático donde dos redes neuronales juegan un juego de gato y ratón. Uno crea imágenes falsas que se parecen a las reales, y el otro decide si son reales.

Las redes adversarias generativas (GAN), a veces llamadas redes generativas, crearon estas imágenes falsas. El equipo de investigación de Nvidia utilizó esta nueva técnica al alimentar miles de fotos de celebridades a una red neuronal. La red neuronal, a su vez, ha producido miles de imágenes, como las de arriba, que se parecen a las caras famosas. Parecen reales, pero las máquinas los crearon. Los GAN permiten a los investigadores crear imágenes que se parezcan a las reales compartiendo muchas características de las imágenes que se alimentaba a la red neuronal. Se pueden alimentar con fotografías de objetos desde mesas hasta animales, y después de ser entrenado, produce imágenes que se parecen a los originales.

Para que el equipo de Nvidia generara estas imágenes, creó dos redes neuronales. Uno que produjo las imágenes y el otro que determinó si eran reales o falsas. La combinación de estas dos redes neuronales produjo una GAN, o red adversaria generativa. Juegan a un juego de gato y ratón, donde uno crea imágenes falsas que se parecen a las reales, y el otro decide si son reales. ¿Esto te recuerda algo? La prueba de Turing. Piensa en las redes como jugando al juego de adivinanzas de si las imágenes son reales o falsas.

Después de que se haya entrenado el GAN, una de las redes neuronales crea imágenes falsas que se parecen a las reales utilizadas en el entrenamiento. Las imágenes resultantes se ven exactamente igual que las fotos de la gente real. Esta técnica puede generar grandes cantidades de datos falsos que pueden ayudar a los investigadores a predecir el futuro o incluso a construir mundos simulados. Es por eso que para Yann LeCun, Director de Facebook AI Research, “Generative Adversarial Networks es la idea más interesante de los últimos diez años en el aprendizaje automático“. * Los GAN serán útiles para crear imágenes y tal vez crear simulaciones de software del mundo real, donde los desarrolladores pueden entrenar y probar otros tipos de software. Por ejemplo, las empresas que escriben software de conducción autónoma para automóviles pueden entrenar y comprobar su software en mundos simulados. Hablaré de esto en detalle más adelante.

Estos mundos y situaciones simulados ahora están hechos a mano por desarrolladores, pero algunos creen que todos estos escenarios serán creados por GAN en el futuro. Los GAN generan nuevas imágenes y vídeos a partir de datos muy comprimidos. Por lo tanto, podrías usar las dos redes neuronales de un GAN para guardar datos y luego restablecerlos. En lugar de comprimir tus archivos, podrías usar una red neuronal para comprimirla y la otra para generar los vídeos o imágenes originales. No es coincidencia que en el cerebro humano parte del aparato utilizado para la imaginación sea el mismo que el utilizado para el recuerdo de la memoria. Demis Hassabis, el fundador de DeepMind, publicó un artículo* que “mostraba sistemáticamente por primera vez que los pacientes con daños en su hipocampo, que se sabe que causan amnesia, tampoco podían imaginarse en nuevas experiencias”. * El hallazgo estableció un vínculo entre el proceso constructivo de la imaginación* y el proceso reconstructivo de recuerdo episódico de la memoria. * Hay más detalles sobre esto más adelante.

EL CREADOR DE GANS

A Ian Goodfellow, el creador de GAN, se le ocurrió la idea en un bar de Montreal cuando estaba con otros investigadores discutiendo lo que implica la creación de fotografías. El plan inicial era entender las estadísticas que determinaban qué creaban las fotos y luego alimentarlas a una máquina para que pudiera producir las imágenes. Goodfellow pensó que la idea nunca funcionaría porque se necesitan demasiadas estadísticas. Así que pensó en usar una herramienta, una red neuronal. Podría enseñar a las redes neuronales a descubrir las características subyacentes de las imágenes alimentadas a la máquina y luego generar otras nuevas.

Goodfellow luego añadió dos redes neuronales para que pudieran construir juntos fotografías realistas. Uno creó imágenes falsas y el otro determinó si eran reales. La idea era que una de las redes adversarias enseñara a la otra a producir imágenes que no se podían distinguir de las reales.

La misma noche que se le ocurrió la idea, se fue a casa, un poco borracho, y se quedó despierto esa noche codificando el concepto inicial de un GAN en su portátil. Funcionó en el primer intento. Unos meses más tarde, él y algunos otros investigadores publicaron el artículo seminal sobre GAN en una conferencia. * El GAN entrenado usó dígitos escritos a mano de un conocido conjunto de imágenes de entrenamiento llamado MNIST.*

En los años siguientes, se publicaron cientos de artículos utilizando la idea de GAN para producir no solo imágenes, sino también vídeos y otros datos. Ahora en Google Brain, Goodfellow dirige un grupo que está haciendo que el entrenamiento de estas dos redes neuronales sea muy fiable. El resultado de este trabajo son servicios que son mucho mejores para generar imágenes y sonidos de aprendizaje, entre otras cosas. “Los modelos aprenden a entender la estructura del mundo”, dice Goodfellow. “Y eso puede ayudar a los sistemas a aprender sin que se les diga explícitamente”.

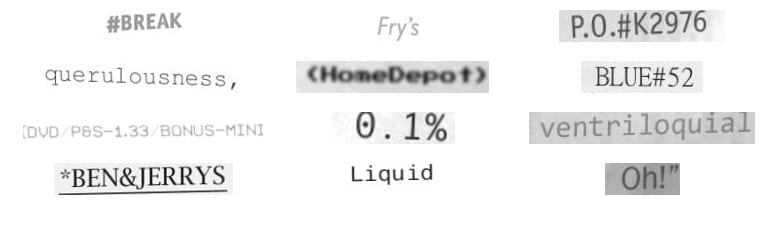

Los GAN podrían eventualmente ayudar a las redes neuronales a aprender con menos datos, generando más imágenes sintéticas que luego se utilizan para identificar y crear mejores redes neuronales. Recientemente, un grupo de investigadores de Dropbox mejoró su escáner de documentos móvil mediante el uso de imágenes generadas sintéticamente. Los GAN produjeron nuevas imágenes de palabras que, a su vez, se utilizaron para entrenar la red neuronal.

Y eso es solo el comienzo. Los investigadores creen que se puede aplicar la misma técnica para desarrollar datos artificiales que se pueden compartir abiertamente en Internet sin revelar la fuente principal, asegurándose de que los datos originales permanezcan privados. Esto permitiría a los investigadores crear y compartir información de atención médica sin compartir datos confidenciales sobre los pacientes.

Los GAN también muestran una promesa para predecir el futuro. Puede sonar como ciencia ficción ahora, pero eso podría cambiar con el tiempo. LeCun está trabajando en el software de escritura que puede generar vídeo de situaciones futuras basado en el vídeo actual. Él cree que la inteligencia humana radica en el hecho de que podemos predecir el futuro y, por lo tanto, los GAN serán una fuerza poderosa para los sistemas de inteligencia artificial en el futuro. *

LA PRUEBA DEL PARADOJA DE CUMPLEAÑOS

A pesar de que los GAN están generando nuevas imágenes y sonidos, algunas personas preguntan si los GAN generan nueva información. Una vez que un GAN está capacitado en una recopilación de datos, ¿puede producir datos que contengan información fuera de sus datos de entrenamiento? ¿Puede crear imágenes que sean completamente diferentes de las que se le dan?

Una forma de analizar eso es por lo que se llama la prueba de paradoja de cumpleaños. Esta prueba deriva su nombre de la implicación de que si pones a 23 -dos equipos de fútbol más un árbitro- personas al azar en una habitación, la posibilidad de que dos de ellos tengan el mismo cumpleaños es de más del 50%.

Este efecto ocurre porque con 365 días al año, necesitas al menos un número de personas alrededor de la raíz cuadrada de eso para ver un cumpleaños duplicado. La paradoja del cumpleaños dice que para una distribución discreta que tiene soporte N, entonces un tamaño de muestra aleatorio de √N probablemente contendría un duplicado. ¿Qué significa eso? Déjame desglosarlo.

Si hay 365 días al año, entonces necesitas la raíz cuadrada de 365 personas, √365, para tener una probabilidad probable de que dos tengan los mismos cumpleaños, lo que significa unas 19 personas. Pero esto también funciona para el otro lado de la ecuación. Si no sabes el número de días en un año, puedes seleccionar un número fijo de personas y pedirles sus cumpleaños. Si hay dos personas con el mismo cumpleaños, puedes inferir el número de días en un año con una alta probabilidad en función del número de personas. Si tienes 22 personas en la habitación, entonces el número de días en un año es el cuadrado de 22…222– unos 484 días al año, una aproximación del número real de días en un año.